Суперкомпьютер для чего он нужен

Квантовое будущее: как работают суперкомпьютеры и зачем они нужны

Ученые из Национального исследовательского технологического института МИСиС (бывший Московский институт стали и сплавов) и Московского физико-технического института (МФТИ) предложили новый подход к созданию квантовых суперкомпьютеров. Российские ученые показали, что на одном чипе возможно фотон-магнонное взаимодействие. Эта разработка, как ожидается, поможет ученым создать гибридный квантовый компьютер. Чем квантовые вычислительные машины отличаются от обычных? По какому принципу они работают и для чего нужны?

Все и сразу – принцип суперпозиции

Эрвин Шредингер в 1935 году удачно проиллюстрировал один из основополагающих принципов квантовой механики – принцип суперпозиции. В его мысленном эксперименте кот, находящийся внутри коробки, с одинаковой вероятностью может быть живым или мертвым, так как никто не может знать, случился ли распад крупицы радиоактивного вещества, открывающей колбу с ядом. Выходит, что кот и жив, и мертв одновременно, что противоречит здравому смыслу.

Принцип суперпозиции используется для вычислений с помощью квантовых компьютеров. В обычном компьютере для вычислений используется двоичный код, состоящий из комбинации нулей и единиц. При этом каждый бит информации может принимать только одно значение – или один, или ноль.

В квантовом компьютере информация кодируется кубитами, которые учитывают все возможные сочетания значений закодированных чисел. Это позволяет одновременно просчитывать все возможные состояния и существенно ускоряет обработку некоторых алгоритмов. Например, квантовые компьютеры теоретически смогут легко справляться с расшифровкой информации – обычным машинам взлом современных систем шифрования практически неподвластен.

Квантовый интеллект

Полезными квантовые компьютеры, по предположениям ученых, будут и для развития искусственного интеллекта, так как они позволяют ускорить процесс машинного обучения и оперируют одновременно огромным массивом информации. Google и Volkswagen даже исследуют возможность применения квантовых компьютеров в разработках искусственного интеллекта и беспилотных автомобилей.

Однако полноценно работающий квантовый компьютер пока существует лишь в теории. Вся проблема заключается в том, что связать множество кубитов в единую действующую сеть чрезвычайно сложно. Чем больше «ячеек» в сети, тем больше их влияние друг на друга и тем ниже точность вычислений. Самые мощные квантовые процессоры состоят примерно из 50 кубитов. Большинство из них не универсальны и подходят для решения всего лишь одной задачи – но они справляются с ней гораздо эффективнее, чем существующие машины.

Мощный суперкомпьютер невозможен?

Некоторые ученые скептически относятся к идее создания огромных квантовых процессоров. Так, российский физик Михаил Дьяконов уверен, что пропасть между теорией квантовых вычислений и практической ее реализацией человечество никогда не преодолеет.

Квантовое превосходство достигнуто

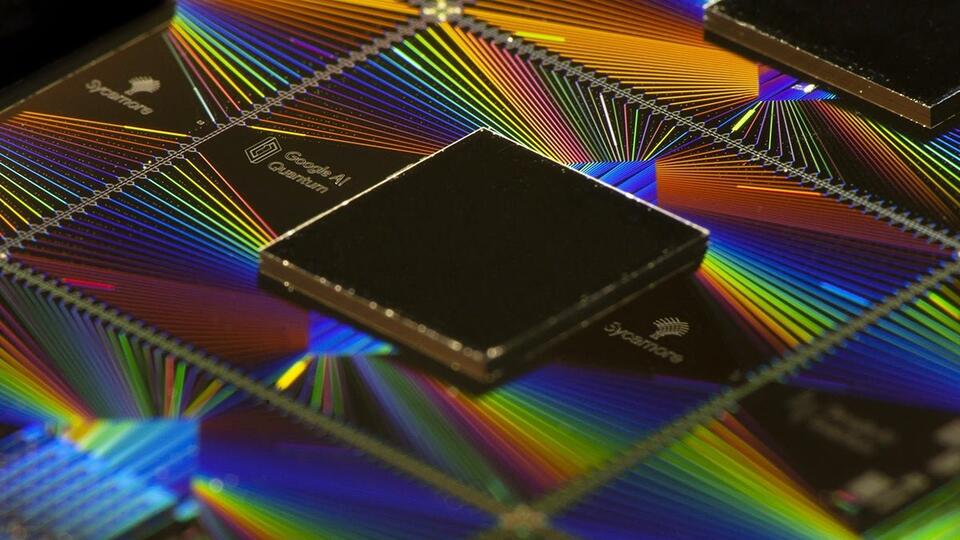

В то же время цифровые корпорации не прекращают работу над квантовыми компьютерами. В 2019 году Google с помощью квантового процессора Sycamore, состоящего из 54 кубитов, за 200 секунд выполнила задание, на которое обычным машинам понадобилось бы около 10 тысяч лет. Компания уверена: их разработка смогла достичь квантового превосходства над обычной техникой. Второй машиной, которой удалось достичь квантового превосходства, стал китайский процессор Jiuzhang, который за 200 секунд выполнил задачу, на которую самые мощные современные компьютеры потратили бы 1,5 миллиарда лет.

От электронов к оптическим «ловушкам»

Технологии производства квантовых компьютеров постоянно совершенствуются. Первые модели были твердотельными, логические кубиты в них кодировались зарядом или положением электрона, а управление осуществлялось с помощью лазера.

Следующим шагом стало создание квантовой машины на сверхпроводниках – здесь информация кодируется с помощью пар электронов, взаимодействующих через фотон. Управлялись такие машины с помощью электрических магнитных полей.

Для создания квантовых машин также использовались особые оптические «ловушки» для заряженных частиц, где для кодирования использовалось основное или возбужденное состояние частиц, а управление велось с помощью лазера.

Гибридные системы наиболее перспективны

Наиболее перспективной технологией, по мнению специалистов, является гибридная, но для этого передаваемую информацию нужно постоянно конвертировать, например, превращать из микроволнового излучения в фотоны света. Система, предложенная учеными из НИТУ МИСиС и МФТИ, позволяет проводить эти преобразования относительно легко, с помощью электромагнитного поля.

Система со сверхсильным фотон-магнонным взаимодействием, предложенная специалистами, обладает силой взаимодействия около 350 Гц – прежние установки имели мощность всего около 100 Гц. Две сверхпроводящие пленки в ней разделены диэлектриком, внутрь помещается ферромагнетик – вещество, обладающее собственным упорядоченным магнитным полем. Электромагнитные волны внутри системы начинают взаимодействовать с ферромагнетиком, и в результате движение фотонов замедляется, что позволяет создать прочную фотон-магнонную связь.

Эксперты, однако, отмечают, что разработка стала настоящим вызовом для ученых, так как магнонные системы по своему размеру гораздо меньше фотонных, что затрудняет их разработку. Однако они гораздо лучше «управляются» с помощью магнитного поля и открывают широкие перспективы не только для создания квантовых суперкомпьютеров, но и для изучения фундаментальных законов физики.

Суперкомпьютер для чего он нужен

Зачем нужны суперкомпьютеры. Российский производитель суперкомпьютеров – компания «Т-Платформы»

Это первый материал из цикла, посвященного суперкомпьютерам и работе на этом рынке российской компании «Т-Платформы». Материалы созданы на основании интервью с Александром Голубом, директором департамента разработки «Т-Платформ», и Сергеем Клейменовым, главным специалистом по интеграции и внедрению, который занимал пост технического руководителя (так называемый «technical lead») проекта по строительству суперкомьютера JURECA.

Основным направлением деятельности компании «Т-Платформы» является создание суперкомпьютеров как в России, так и за рубежом, хотя сейчас компания активно работает и на других направлениях, в первую очередь это создание и продажа серверов общего назначения, созданных на базе суперкомпьютерных технологий.

Одна из основных особенностей компании состоит в том, что в «Т-Платформах» самостоятельно разрабатывают дизайн шасси, платформ и даже материнских плат и плат расширения (что требует хорошего знания элементной базы и взаимодействия с производителями чипов), а также самостоятельно пишут все управляющее ПО, начиная от микропрограммы для контроллера управления серверной платой (BMC), BIOS-а, плат управления шасси и заканчивая программами для управления ресурсами суперкомпьютеров.

Что такое суперкомпьютеры и зачем они нужны?

В современном мире время играет не меньшую, а иногда и большую роль, чем деньги. Иногда время вообще становится единственным решающим фактором: если продукт или технология не появились на рынке в нужный срок, то они уже никому не нужны, даже если по остальным направлениям все выглядит неплохо. Математическое моделирование и численные методы стали одним из способов радикально сократить затраты времени и денег на разработку новых технологий и продуктов.

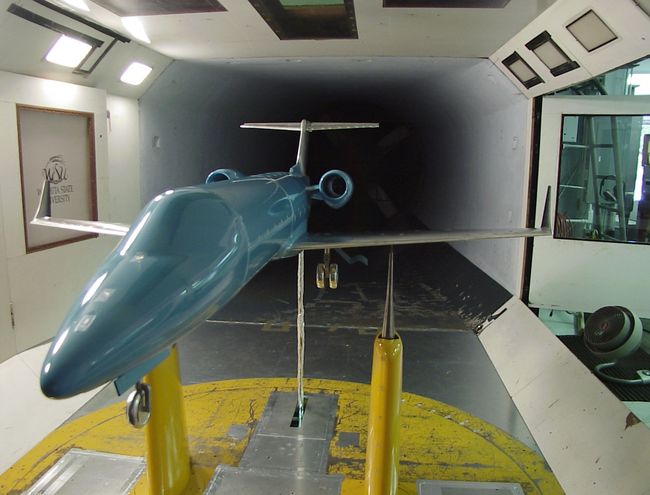

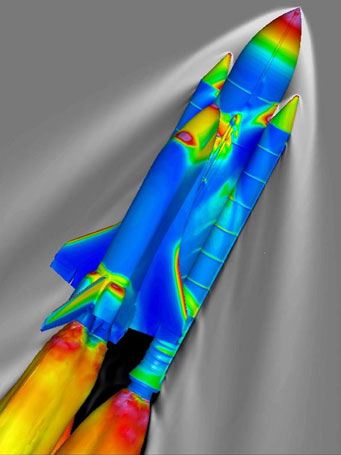

Традиционная физическая модель для продува. Источник

Например, одним из самых сложных и дорогостоящих процессов при создании нового самолета является разработка оптимального планера. Раньше для этого приходилось вручную строить десятки моделей, а потом продувать их в аэродинамической трубе. Компьютерное моделирование позволяет сравнить разные варианты, найти оптимальный и «довести» его, не прибегая постройке моделей и натурным испытаниям. Еще больше выгод компьютерное моделирование предлагает в ситуациях, когда есть несколько вариантов решения и заранее непонятно, какой из них лучше.

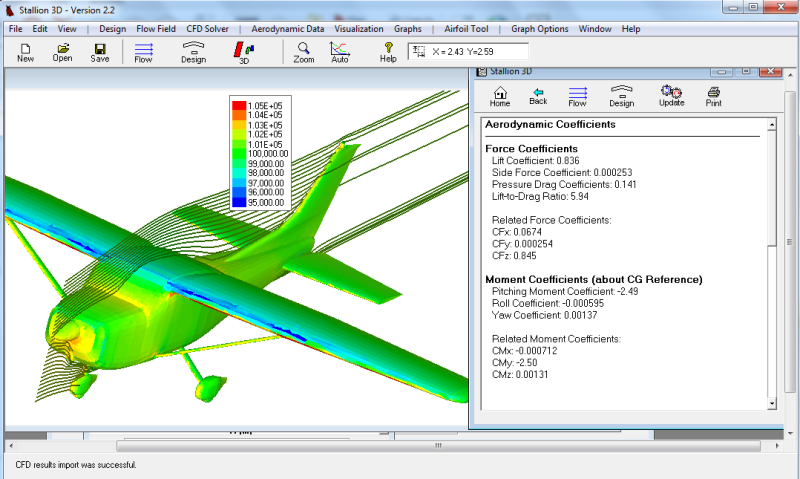

Компьютерная модель самолета для анализа внешних воздействий. Источник

Пример ПО для расчета аэродинамики. Источник

Кто использует моделирование с помощью суперкомпьютеров

Компьютерное моделирование широко применяется подавляющим большинством компаний, занимающихся разработкой новых технологий и продуктов, а количество специализированного ПО для моделирования на все случаи жизни достаточно велико. Правда, даже сегодня многие компании не осознают до конца преимуществ высокопроизводительных систем и не исследуют возможности их использования для своих задач. Много где моделирование до сих пор осуществляется на рабочих станциях, из-за чего выполнение проектов занимает довольно много времени.

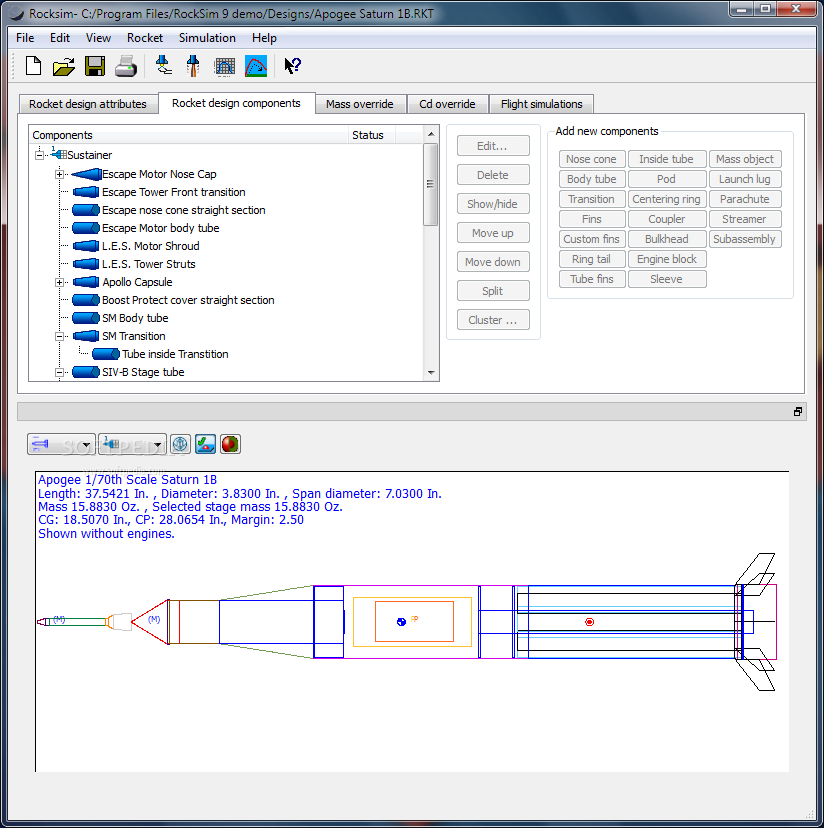

ПО для моделирования ракет. Источник

Сегодня ресурсы суперкомпьютеров в значительной степени используются для решения научных задач, а главным заказчиком является научное сообщество. Суперкомпьютеры обслуживают научные расчеты в огромном количестве самых разных областей науки, таких как биотехнологии (например, это одно из популярных направлений для суперкомпьютеров в МГУ), фармацевтика, фармакология, аэродинамика и авионика, гидродинамика и кораблестроение, двигателестроение, ракетные двигатели и ракетные технологии, энергетика, добыча полезных ископаемых и огромное количество других направлений.

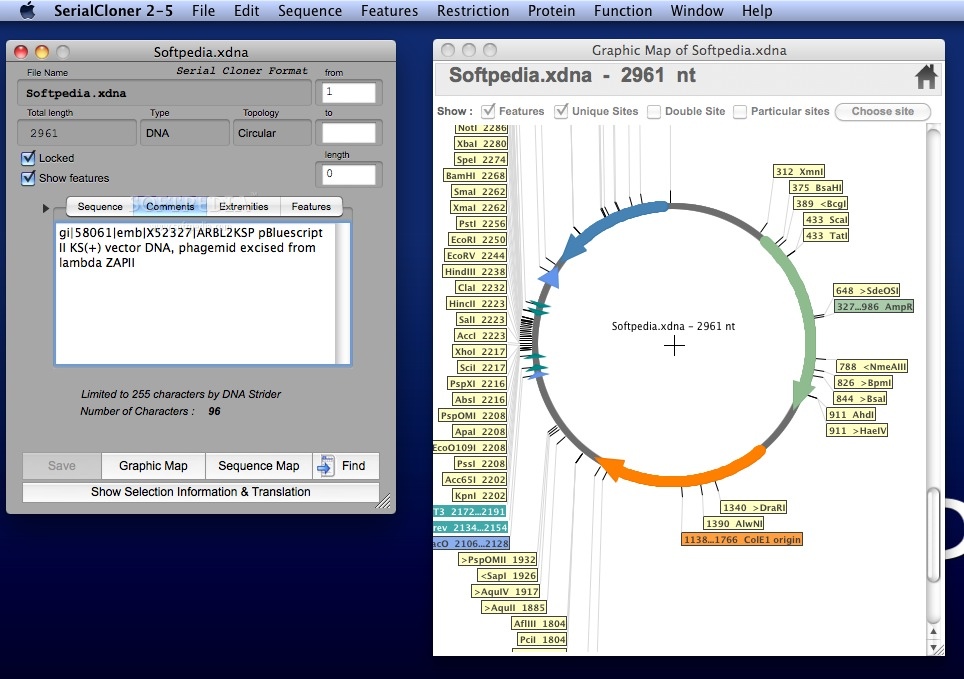

ПО для работы с генетической информацией ДНК. Источник

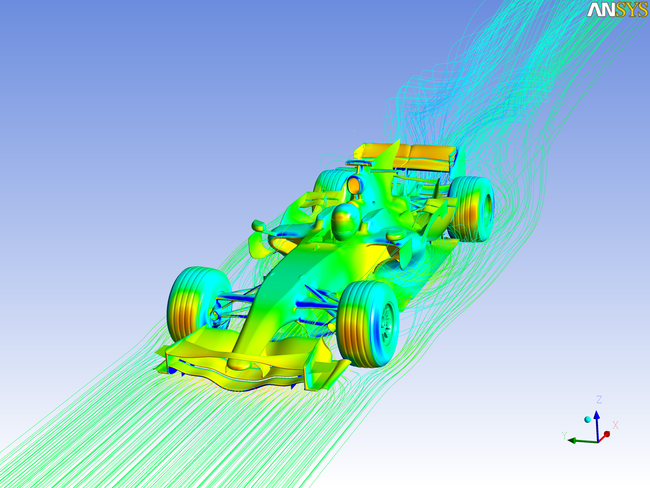

Впрочем, преимущества суперкомпьютера раскрываются в решении крупных прикладных и научных задач. Для распространенных прикладных задач существует специализированное ПО: пакеты ANSYS, Solidworks (эти компании имеют большое количество продуктов под решение разных задач), Abaqus, Deform 3D, Flow Vision, Open FOAM, Autodesk Simulation и многие другие. Разные продукты оптимизированы под решение разных типов задач, некоторые производители поддерживают широкую линейку продуктов, некоторые сосредотачиваются на определенных направлениях.

А вот при решении задач в рамках научных исследований ПО для расчетов часто приходится разрабатывать самостоятельно.

Пример расчета аэродинамики в ПО ANSYS. Источник

Рынок суперкомпьютеров заметно отличается от рынка серверов общего назначения: здесь используются свои уникальные технологии, свои технические решения, свои серверные платформы и конфигурации, свои виды интерконнекта (связь между серверами) и т.д.

Средний размер системы на этом рынке относительно небольшой: проект в 1000 блейд-систем считается крупным. Но при этом каждый проект имеет свои уникальные особенности, потому что практически везде заказчик выдвигает особые требования: специфические конфигурации, особые виды интерконнекта, своя конструкция стоек, своя конфигурация СХД, особенности помещения и т.д. В результате, каждый проект требует отдельной работы архитекторов и инженеров кластерных решений, которые создают проект с учетом специфики заказчика.

Кроме того, проекты часто требуют решения различных инженерных задач. В первую очередь это создание инженерных систем для обеспечения работы суперкомпьютера, в первую очередь надежного энергоснабжения и охлаждения. Очень часто требуется адаптировать эти системы (а иногда и вычислительные системы) под особенности помещения.

Впрочем, уникальные особенности проекта редко составляют более 15% от общего объема работ. Выбор на рынке все же ограничен, поэтому с подавляющим большинством технологий, продуктов и решений, присутствующих на рынке, специалисты компании уже знакомы, так как сталкивались раньше. Хотя изредка, когда речь идет о совсем экзотических или ультрасовременных технологиях, приходится брать их отдельно и устраивать дополнительное тестирование на своих мощностях, чтобы понять, что это и как оно работает.

На сегодня компанией «Т-Платформы» накоплен огромный объем знаний и опыта, которые позволяют ей оставаться одним из лидеров рынка суперкомпьютеров.

5 самых мощных суперкомпьютеров: для чего они нужны?

Модели с огромной производительностью, укомплектованные тысячами процессоров и десятками гигабайт ОЗУ, называются суперкомпьютерами. Самые мощные можно найти в списке TOP500, где первые 5 мест занимают американские модели Summit и Sierra, китайские ЭВМ Sunway TaihuLight и Тяньхэ-2, а также швейцарский Piz Daint.

Что такое суперкомпьютер

СуперЭВМ – название, которое получают специализированные вычислительные машины, превосходящие по характеристикам и скорости вычисления большинство обычных компьютеров.

Суперкомпьютер состоит из большого количества многоядерных систем, объединенных в общую систему для получения высокой производительности. Еще одно отличие от обычных ПК – большие размеры. Техника располагается в нескольких помещениях, занимая целые этажи и здания.

Первым настоящим суперкомпьютером считается собранный в 1974 году в США ПК Cray-1. Благодаря поддержке векторных операций модель выполняла до 180 млн вычислений с плавающей точкой в секунду (флопс). Большая часть суперЭВМ по-прежнему собирается и используется в Соединенных Штатах, следующими по количеству такой техники идут Китай и Япония.

Назначение суперкомпьютеров

Суперкомпьютеры решают разнообразные задачи – от сложных математических расчетов и обработки огромных массивов данных до моделирования искусственного интеллекта. Есть модели, воспроизводящие «архитектуру» человеческого мозга. На СуперЭВМ проектируют промышленное оборудование и электронику, синтезируют новые материалы и делают научные открытия.

Автомобилестроительные компании используют суперкомпьютеры для имитации результатов краш-тестов, экономя средства на настоящих испытаниях. Подходит такая мощная техника и для разработки новых двигателей, позволяя моделировать специальный температурный режим и процессы деформации. С ее же помощью можно прогнозировать метеорологические явления и даже землетрясения.

1. Summit

Суперкомпьютер Summit, созданный американской компанией IBM для Национальной лаборатории в Окридже. Технику ввели в эксплуатацию летом 2018 года, заменив модель Titan, которая считалась самой производительной американской СуперЭВМ. Разработка лучшего современного суперкомпьютера обошлась американскому правительству в 200 млн долларов.

Устройство потребляет около 15 МВт электроэнергии – столько, сколько вырабатывает небольшая ГЭС. Для охлаждения вычислительной системы используется 15,1 кубометра циркулирующей по трубкам воды. Сервера IBM расположены на площади около 930 кв.м – территория, которую занимают 2 баскетбольные площадки. Для работы суперкомпьютера используется 220 км электрокабелей.

Производительность компьютера обеспечивается 9216 процессорами модели IBM POWER9 и 27648 графическими чипами Tesla V100 от Nvidia. Система получила целых 512 Гбайт оперативной и 250 Пбайт постоянной памяти (интерфейс 2,5 Тбайт/с). Максимальная скорость вычислений – 200 Пфлопс, а номинальная производительность – 143,5 Пфлопс.

По словам американских ученых, запуск в работу модели Summit позволил повысить вычислительные мощности в сфере энергетики, экономическую конкурентоспособность и национальную безопасность страны. Среди задач, которые будут решаться с помощью суперкомпьютера, отмечают поиск связи между раковыми заболеваниями и генами живого организма, исследование причин появления зависимости от наркотиков и климатическое моделирование для составления точных прогнозов погоды.

2. Sierra

Второй американский суперкомпьютер Sierra (ATS-2) тоже выпущен в 2018 году и обошелся Соединенным Штатам примерно в 125 миллионов долларов. По производительности он считается вторым, хотя по среднему и максимальному уровню скорости вычислений сравним с китайской моделью Sunway TaihuLight.

Расположена СуперЭВМ на территории Национальной лаборатории имени Э. Лоуренса в Ливерморе. Общая площадь, которую занимает оборудование, составляет около 600 кв.м. Энергопотребление вычислительной системы – 12 МВт. И уже по соотношению производительность к расходу электричества компьютер заметно обогнал конкурента из КНР.

В системе используется 2 вида процессоров – серверные ЦПУ IBM Power 9 и графические Nvidia Volta. Благодаря этим чипам удалось повысить и энергоэффективность, и производительность. 4320 узлов со 190 тысячами ядер обеспечивают вычисления на скорости 94,64 петафлопс. Максимальная производительность – 125,712 Пфлопс или 125 квадриллионов операций с плавающей точкой в секунду.

3. Sunway TaihuLight

Китайская СуперЭВМ удерживала лидирующую позицию в рейтинге TOP500 с 2016 до 2018 года. В соответствии с тестами LINPACK ее считали самым производительным суперкомпьютером, минимум в полтора раза превосходящим ближайшего конкурента и втрое опережающим самую производительную американскую модель Titan. Разработка и строительство вычислительной системы обошлось в 1,8 млрд. юаней или 270 млн долларов. Инвесторами проекта были правительство Китая, администрация китайской провинции Цзянсу и города Уси.

Суперкомпьютер потребляет 15,3 МВт электроэнергии и занимает площадь 605 кв.м. Расположен он на территории города Уси, в национальном суперкомпьютерном центре. Название модели дали в честь расположенного рядом озера Тайху, третьего по величине пресноводного водоема Китая.

Наличие в конструкции ЭВМ 41 тысячи процессоров SW26010 и 10,6 миллиона ядер позволяет ей проводить расчеты со скоростью 93 Пфлопс. Максимальная производительность – 125 Пфлопс. Переход на чипы китайского производства потребовал от разработчиков создания полностью новой системы. До этого предполагалось в 2 раза повысить производительность другой китайской СуперЭВМ Тяньхэ-2, но эти намерения пришлось изменить из-за проблем с поставками процессоров Intel из США.

Модель Sunway TaihuLight применяется для выполнения сложных вычислений в области медицины, горнодобывающей промышленности и производстве. С помощью вычислительной машины прогнозируют погоду, исследуют новые лекарства и анализируют «большие данные» – массивы информации, обработать которые не получится даже у самого мощного серийного компьютера.

4. Тяньхэ-2

Суперкомпьютер Tianhe-2 («Млечный путь»), а, точнее, уже дополненная и модернизированная версия 2А, была разработана сотрудниками компании Inspur и научно-технического университета Народно-освободительной армии Китая. В июле 2013 года модель считалась самой производительной в мире и уступила пальму первенства только другому китайскому компьютеру TaihuLight. На сборку ЭВМ потратили около 200 млн долларов.

Сначала вычислительная система находилась на территории университета, а затем была перемещена в суперкомпьютерный центр в Гуанчжоу. Общая площадь, которую она занимает – около 720 кв. м. Энергопотребление модели составляет 17,8 МВт, что делает ее использование менее выгодным по сравнению с более современными версиями.

Техника построена на базе 80 тысяч ЦПУ Intel Xeon и Xeon Phi. Объем оперативной памяти – 1400 Гбайт, количество вычислительных ядер – больше 3 миллионов. На суперкомпьютере установлена операционная система Kylin Linux. Первые показатели работы системы – 33,8 Пфлопс, современная модификация достигает скорости вычислений 61,4 Пфлопс, максимальная – 100,679 Пфлопс.

СуперЭВМ создали по требованию китайского правительства, его основными задачами являются расчеты для проектов национального масштаба. С помощью системы решаются вопросы безопасности Китая, выполняется моделирование и анализ большого количества научной информации.

5. Piz Daint

Суперкомпьютер Piz Daint достаточно долго (с 2013 до 2018 года) занимал третье место в рейтинге самых мощных вычислительных систем в мире. В то же время он остается самым производительным компьютером Европы. Стоимость проекта составила около 40 млн швейцарских франков.

Модель получила название в честь одноименной территории в Швейцарских Альпах и находится в национальном суперкомпьютерном центре. Оборудование, из которого состоит СуперЭВМ, располагается в 28 стойках. Для работы техники требуется 2,3 МВт электричества, и по этому показателю Piz Daint обеспечивает лучшую удельную производительность – 9,2 Пфлопс/МВт.

В составе ЭВМ есть другой суперкомпьютер Piz Dora, сначала работавший отдельно. После объединения мощностей швейцарские разработчики получили вычислительную систему с 362 тысячами ядер (процессоры Xeon E5-2690v3) номинальной производительностью 21,23 Пфлопс. Максимальная скорость работы – 27 Пфлопс.

Основные задачи суперкомпьютера – расчеты для исследований в области геофизики, метеорологии, физике и климатологии. Одно из приложений для ЭВМ, COSMO, представляет собой метеорологическую модель и используется метеослужбами Германии и Швейцарии для получения высокоточных прогнозов погоды.

Как появились суперкомпьютеры и зачем они нужны

Компьютерное моделирование, использующие параллельные вычислительные алгоритмы, возникло примерно в конце 40-х — начале 50-х годов XX века. Тогда компьютерная эра только начиналась: появился первый компьютер ENIAC в Америке, а также первая советская ЭВМ, которая была разработана группой академика Лебедева. Однако самые первые электронные устройства использовались очень ограниченно, в основном вычисления проводились с помощью большого количества девушек, которые с арифмометрами в руках сидели в большой комнате, напоминавшей спортзал.

Разумеется, осуществлять таким образом последовательные вычисления для решения сложных математических задач было очень тяжело. Поэтому математикам пришлось задуматься над тем, как наиболее эффективно «распараллеливать» вычислительный процесс. Все современные суперкомпьютерные системы используют распараллеленные алгоритмы. Но зародились они именно тогда, еще в начале 1950-х годов с помощью арифмометров, так как другого варианта просто не было. Вычислительная техника развивалась одновременно с вычислительными методами.

Сильным толчком к этому развитию стала в первую очередь работа над ядерными программами.

Первая советская электронно-вычислительная машина была создана в 1951 году школой академика Лебедева. Почти через год аналогичный — полностью электронный — компьютер знаменитого фон Неймана появился в Америке. Тут же возникла задача о последствиях распространения ядерного взрыва, которая решалась параллельно и у нас, и за океаном. Но, конечно, все исследования и разработки велись в рамках совершенно секретных программ.

Тогда же фактически начала развиваться так называемая теория разностных схем и решение дифференциальных уравнений в частных производных. А это основа уравнений математической физики, которые описывают основные физические процессы. Выдающимися исследователями в этой области стали Лакс, Вендрофф, Курант, Гельфанд, академики Белоцерковский, Годунов, Самарский, Дородницын, Яненко. Все эти люди параллельно развивали вычислительную технику и вычислительные методы. Именно тогда появились знаменитые схемы Лакса, Лакса — Вендроффа, метод Годунова, который до сих пор не потерял актуальность, хотя прошло уже более 60 лет. Белоцерковский стал первым ученым, который смог численно решить задачу об обтекании спускаемого в атмосфере Земли аппарата. Кроме того, был создан знаменитый метод Белоцерковского — Дородницына, который используется и сейчас. Тогда же были предложены схемы академика Самарского, по которым сейчас решаются многие математически сложные задачи.

Конечно, наличие всех этих и подобных им задач стимулировало развитие вычислительной техники. И в Советском Союзе она развивалась очень неплохо. Примерно до середины 1960-х годов мы шли параллельно с американцами. Но потом некоторые не совсем профессиональные решения на самых верхах государства привели к тому, что развитие нашей электронной техники и ее финансирование стали сокращаться, а был взят курс на закупку американской вычислительной техники.

Это стало очень большой ошибкой.

Современные суперкомпьютеры — это очень мощные вычислительные системы. Скорость их работы уже достигает десяти и более петафлопс. Хотя буквально 3-5 лет назад речь шла о терафлопсах (1 петафлопс = 10 15 операций в секунду, 1 терафлопс = 10 12 операций в секунду. – Forbes). Сейчас уже идет речь о создании первого экзафлопсного (10 18 операций в секунду) компьютера.

Мощность вычислительной техники в наши дни увеличивается с поразительной скоростью. Правда, физики тоже не отстают и ставят задачи соответствующей сложности. Последнее десятилетие дало удивительный скачок в решении сложнейших задач.

Основное применение вычислительных систем — это моделирование разнообразных физических явлений и процессов. Это нелинейные трехмерные динамические задачи, решать которые стало возможно буквально в последние десятилетия. Это задачи вычислительной аэродинамики (обтекания потоком воздуха самолетов и спускаемых в атмосфере планет аппаратов), гидродинамики (обтекание кораблей, подводных лодок, других плавающих объектов), магнитной гидродинамики, физики плазмы, звезд, сейсморазведки полезных ископаемых и др. С этими задачами связаны такие области информатики, как 3D-компьютерная графика, без которой невозможен анализ результатов расчетов, сетевые технологии, оптимизация программ, интегрирование больших программных комплексов, создание параллельных алгоритмов и распределенные системы.

Специалист в нашей области должен быть прекрасным программистом, знать практически всю информатику, также он должен быть отличным математиком, знать численные методы и предметную область, в которой он работает. Сейчас наши суперкомпьютеры также позволяют решать такие задачи, о которых раньше тяжело было говорить, например климатические, в частности, задачи о движении воздушных масс в атмосфере Земли, океанических течений, взаимодействия океана и атмосферы, образования цунами, действия землетрясений и других природных явлений.