Технический аудит сайта для чего

Технический аудит сайта: когда проводить, какие инструменты использовать и что проверять

Когда нужно проводить технический аудит, с какой периодичностью

Технический аудит сайта обязательно проводится перед запуском проекта, после редизайна, переезда, изменения структуры, а также не реже одного раза в один-два месяца (зависит от размера ресурса).

Какие инструменты использовать

Для проведения технического аудита вам понадобятся:

C помощью сервиса Яндекс.Вебмастер можно узнать:

— какие страницы проиндексированы и участвуют в поиске, а какие – отдают ошибки;

— информацию о добавленных или удалённых страницах;

— о вирусах и вредоносном коде, наложенных фильтрах;

— скорость загрузки страниц;

— настройки региональности сайта;

— файл robots.txt;

— файлы Sitemap и т. д.

C помощью сервиса Google Search Console можно проверить:

— нет ли на сайте внутренних дублей или дублирования заголовков и метаописаний;

— применённые к сайту фильтры;

— ошибки внутри сайта, связанные с недоступностью страниц;

— информацию о поисковой видимости и посещаемости сайта;

— внешние ссылки: общее количество ссылок, какие сайты и страницы ссылаются на вас, на какие страницы вашего сайта ведут ссылки, какие анкоры (тексты) у ссылок;

— как распределяются внутренние ссылки сайта;

— удобство просмотра на мобильных устройствах;

— заблокированные ресурсы;

— ошибки сканирования;

— файл robots.txt;

— файлы Sitemap.

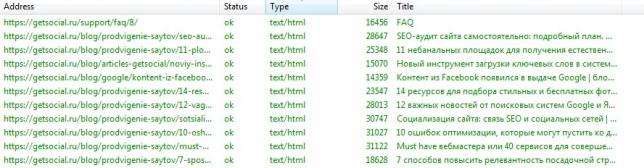

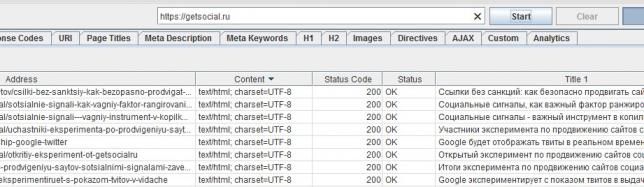

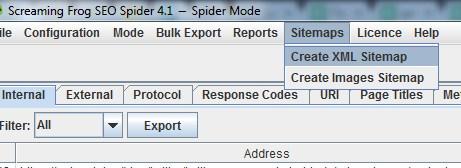

С помощью парсера можно проанализировать техническую составляющую сайта. Программа позволяет выявить множество технических ошибок: битые ссылки, дубли Title, Description и заголовков H, неисправные редиректы, уровень вложенности и т. д.

Есть платные (ComparseR, Netpeak Spider, Screaming Frog и др.) и бесплатные (WildShark SEO Spider, Xenu, Majento SiteAnalayzer 1.4.4.91 и т. д.) программы. Они помогут выявить и устранить технические ошибки, которые мешают продвижению.

Подробный обзор наиболее популярных парсеров в нашем блоге – «Обзор ТОП-6 парсеров сайтов».

Что нужно проверять

Код ответа сервера

При проверке кода ответа сервера убедитесь, что:

— Для склеивания страниц на сайте используется 301 редирект вместо 302.

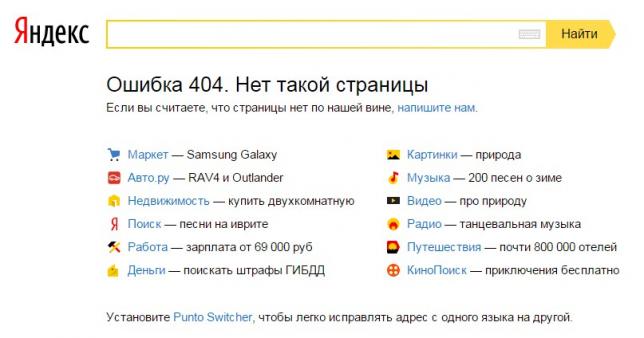

— Все несуществующие страницы отдают 404 код ответа сервера. Также проверьте, настроена ли страница 404 ошибки. Для этого введите любую несуществующую страницу на сайте и посмотрите, что будет видеть пользователь: понятно ли, что это страница ошибки, есть ли ссылки на другие разделы сайта, логотип и т. д. О том, как оформить страницу 404, подробно описано в статье «Error 404 — что значит, как найти и исправить ошибку».

— Все существующие и нужные страницы отдают 200 ОК.

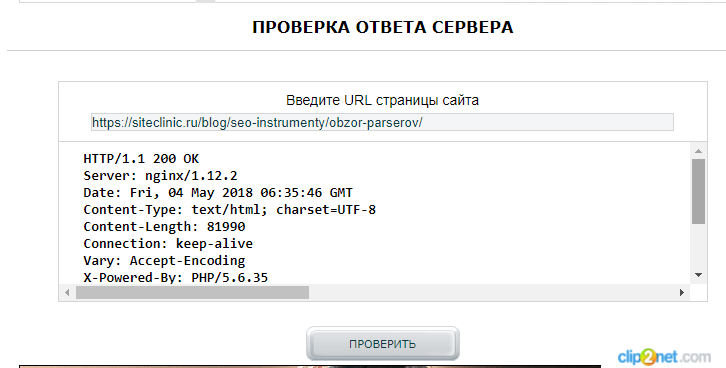

Код ответа сервера можно проверить с помощью онлайн-сервиса Mainspy.ru.

Для проверки нужно ввести URL страницы и нажать на кнопку «Проверить».

Также можно использовать Яндекс.Вебмастер или расширения для браузеров:

С их помощью можно в один клик получить информацию по отдельным страницам.

Битые ссылки

Чаще всего причиной появления битых ссылок становится удаление старых ненужных страниц и файлов или изменения в структуре сайта.

Для проверки сайта на наличие внутренних и внешних битых ссылок можно использовать:

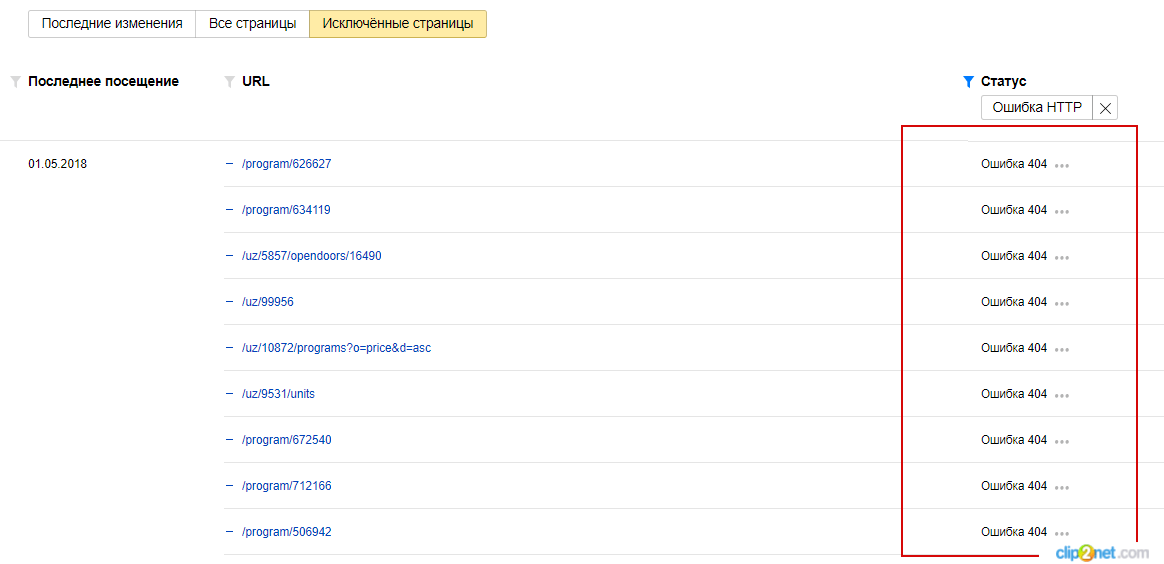

Для этого перейдите в «Индексирование» → «Страницы в поиске» → «Исключенные страницы» → «Ошибка 404»:

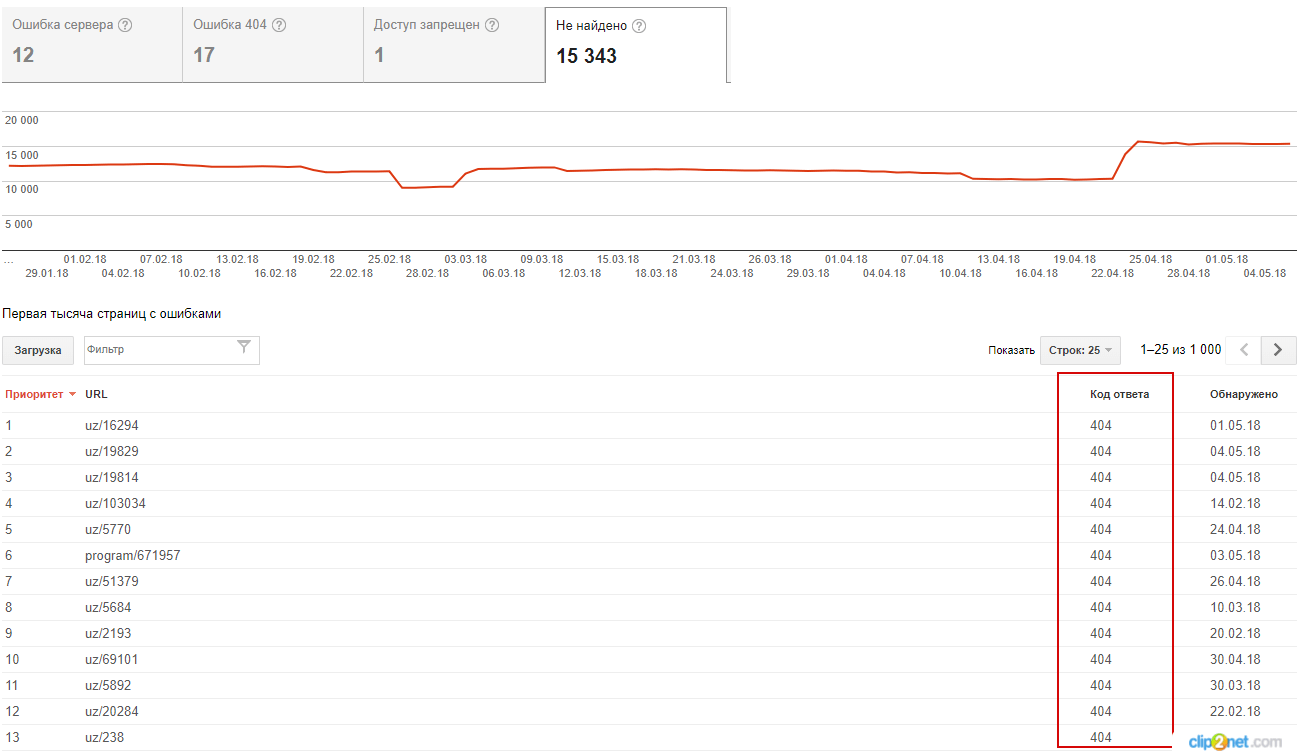

Зайдите в Search Console → «Сканирование» → «Ошибки сканирования» → «Ошибка 404»:

— бесплатные программы WildShark SEO Spider, Xenu, Majento SiteAnalayzer 1.4.4.

После того как будут найдены битые ссылки, определите, что делать с каждой из них:

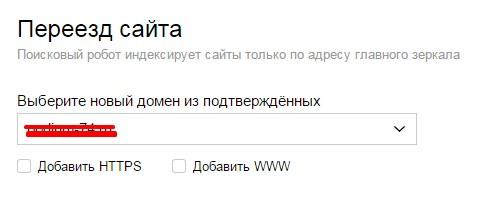

Корректная настройка зеркал сайта

Чаще всего зеркало сайта возникает из-за www-префикса. Также бывают случаи, когда при переезде на другой домен забывают настроить 301-й редирект.

Убедитесь, что у сайта одно главное зеркало. Для этого надо проверить:

— настроен ли 301-й редирект с дубликатов на основной сайт;

— правильно ли указан основной домен в панелях Google Search Console, Яндекс.Вебмастере и файле robots.txt.

Внутренние дубли

Проверьте, нет ли на сайте дублей. Внутренние дубли могут привести к ухудшению индексации сайта, смене релевантной страницы в выдаче и понижению позиций.

Часто встречаются внутренние дубли, когда:

Основные методы поиска дублей на сайте

1. Яндекс.Вебмастер

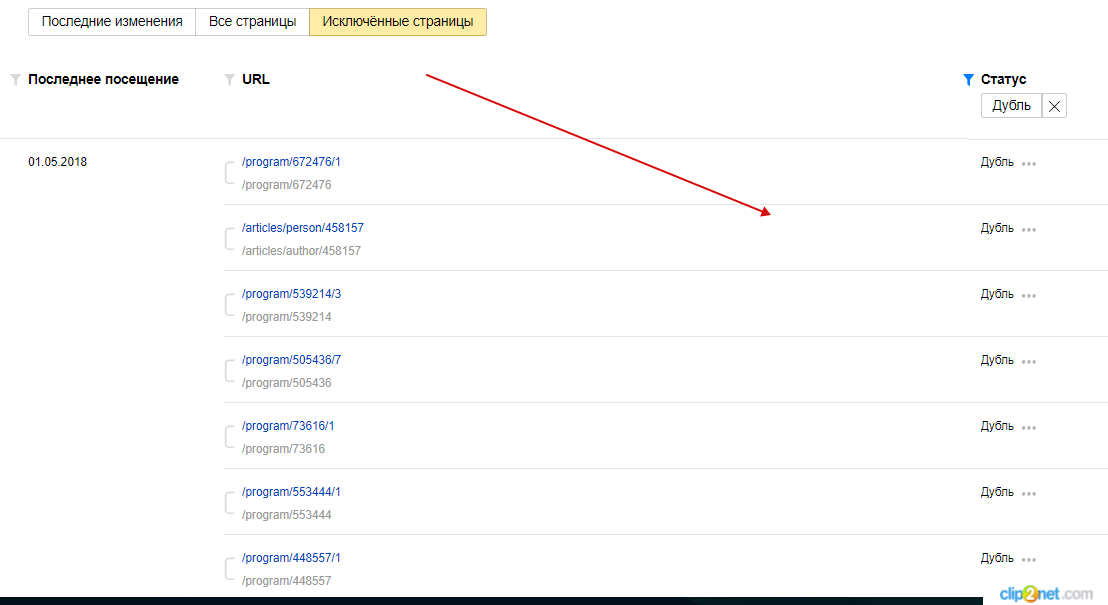

Зайдите в Яндекс.Вебмастер → «Индексирование» → «Страницы в поиске» → «Исключенные страницы», выберите статус «Дубль».

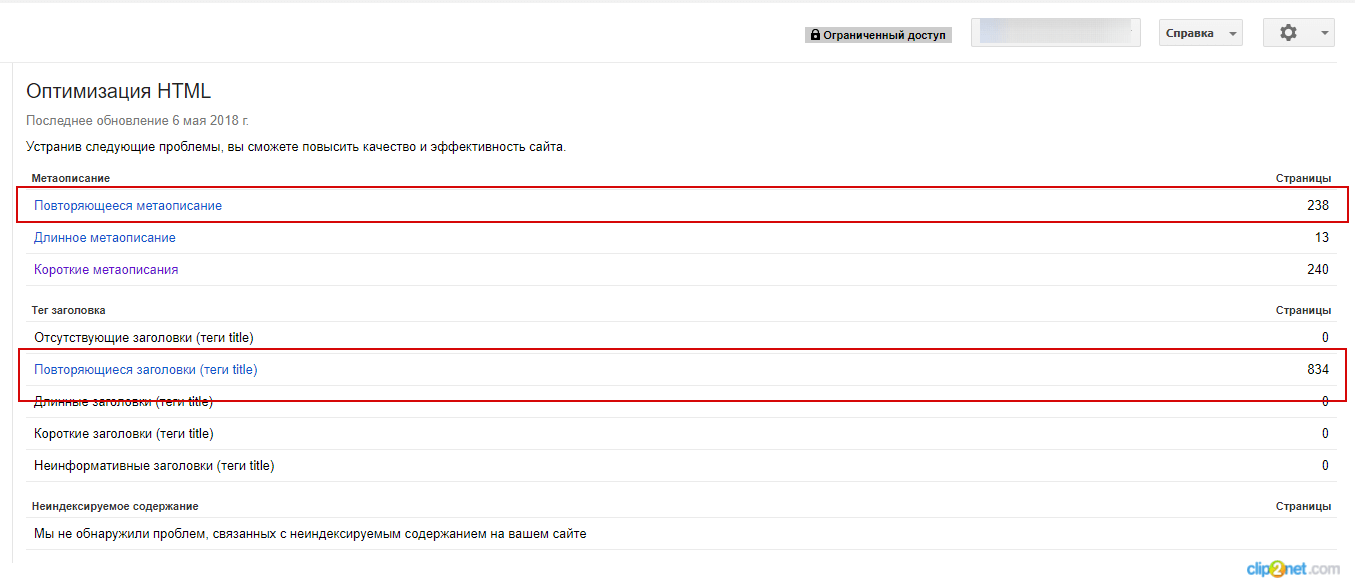

2. Панели вебмастеров Google

Зайдите в Search Console → «Оптимизация» → «Оптимизация HTML». На этой странице можно увидеть количество повторяющихся метатегов и заголовков Title.

Так можно найти полные дубли страниц:

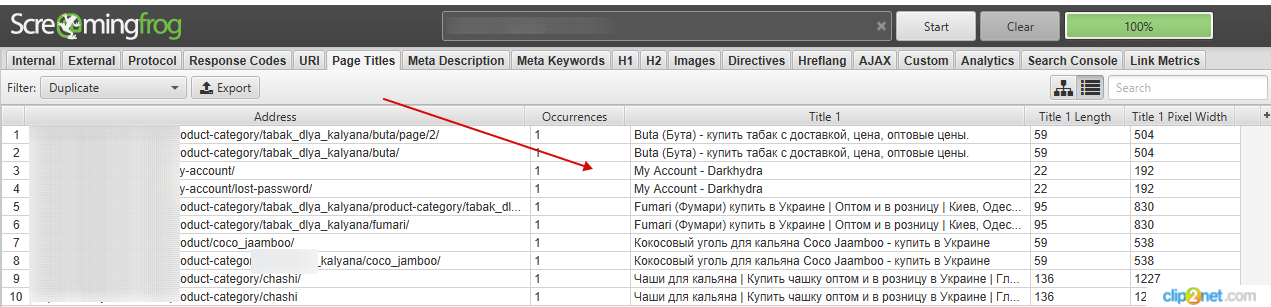

3. Парсер

Для поиска дублей можно воспользоваться одним из популярных парсеров. Например: WildShark SEO Spider, Xenu, Majento SiteAnalayzer 1.4.4.91, SEO Spider и т. д.

Для этого просканируйте сайт, отсортируйте результаты по заголовку и ищите визуальные совпадения заголовков.

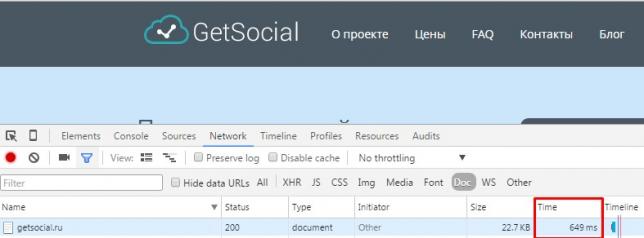

Скорость загрузки сайта

Проверьте скорость загрузки сайта. Исходя из собственной практики и рекомендаций поисковых систем, мы можем определить следующие требования:

— Время до первого байта (TTFB): до 300 мс. Google в своей справке рекомендует 200 мс, но на практике загрузка и 300 мс. не всегда возможна.

— Время загрузки страницы: 3–5 с.

— Время рендеринга: до 1,5 с.

Нужно отметить, что на ранжирование, прежде всего, влияет время ответа сервера (получение первого байта).

Если ваше значение выше, постарайтесь ускорить загрузку сайта.

Сервисы проверки скорости загрузки:

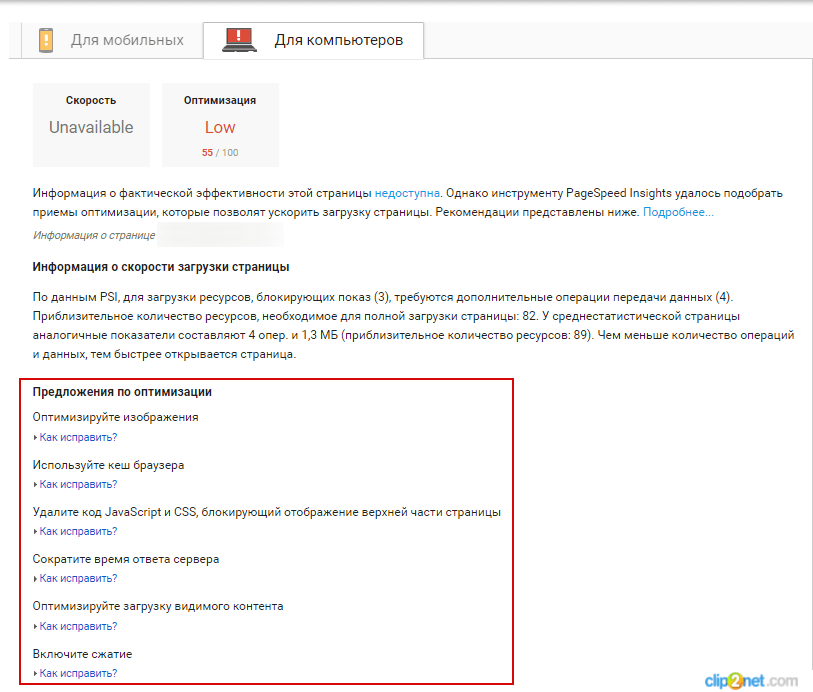

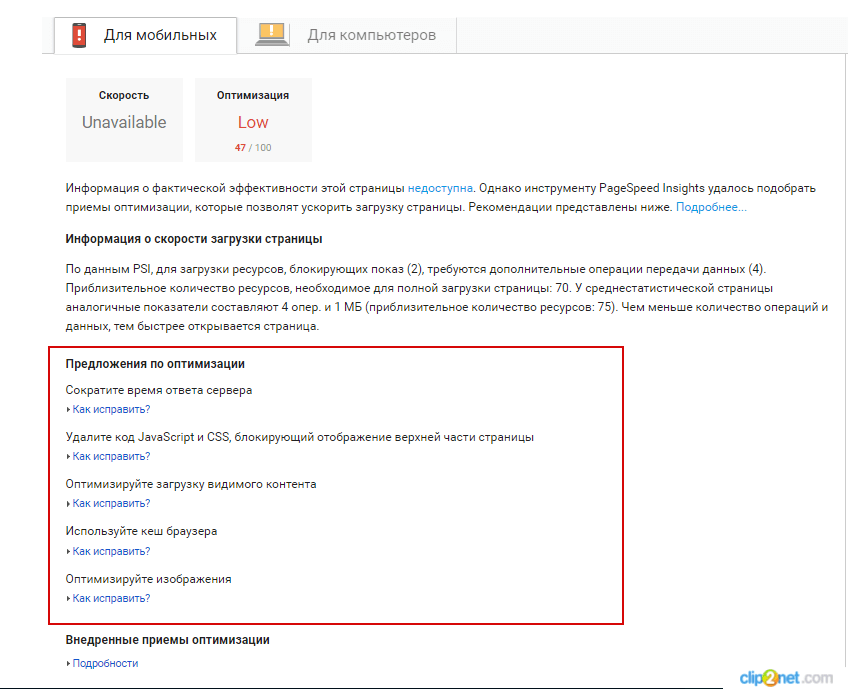

Увидеть, есть ли недочёты, можно с помощью сервиса Google PageSpeed

Подробнее узнать, как оптимизировать скорость загрузки сайта, можно здесь.

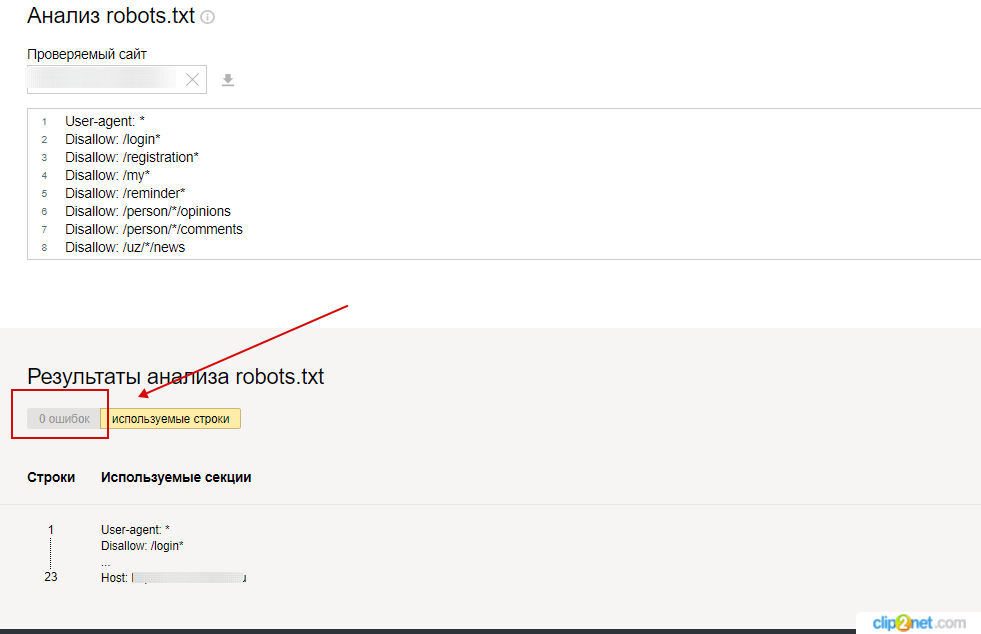

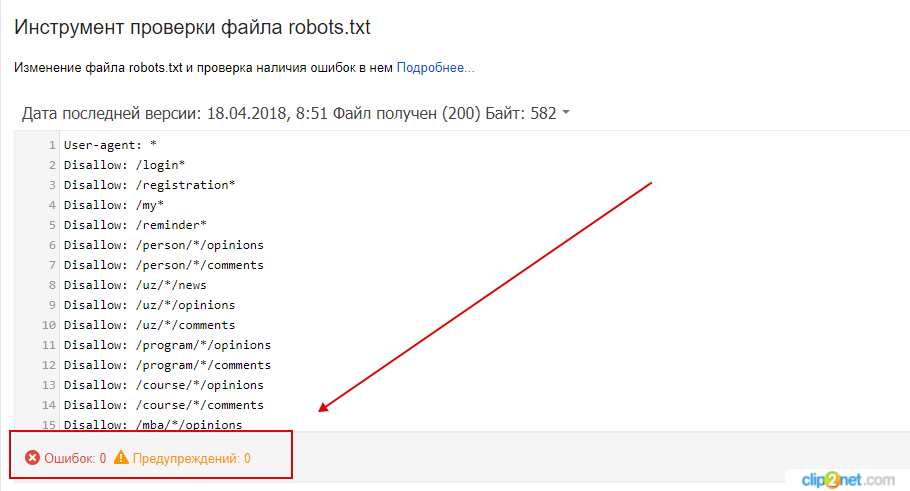

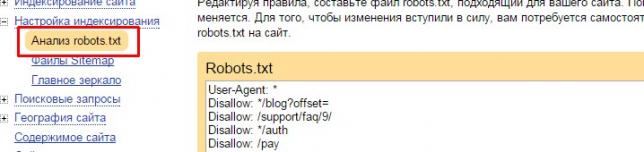

Наличие корректно настроенного файла robots.txt

Проверьте, заполнен ли robots.txt в соответствии с правилами, не допущены ли при его создании ошибки.

Перечень ошибок, возникающих при анализе robots.txt, можно посмотреть в Яндекс.Помощь.

Проверить файл можно с помощью сервисов:

— Яндекс.Вебмастер

Яндекс.Вебмастер → «Анализ robots.txt».

— Google Search Console

Гайд по robots.txt: как создать, настроить и проверить.

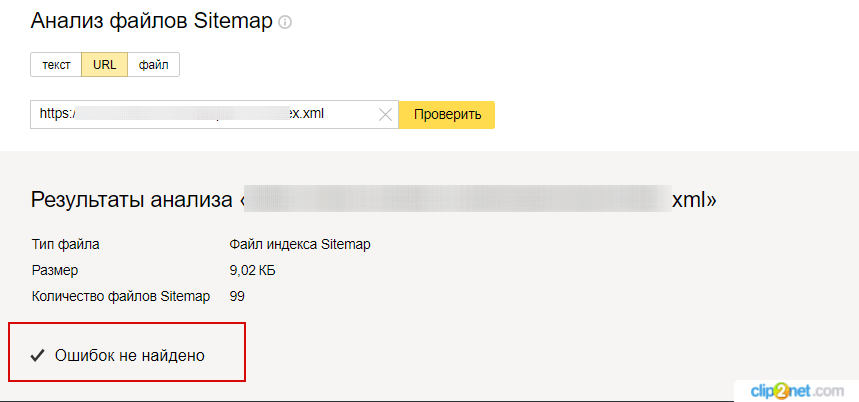

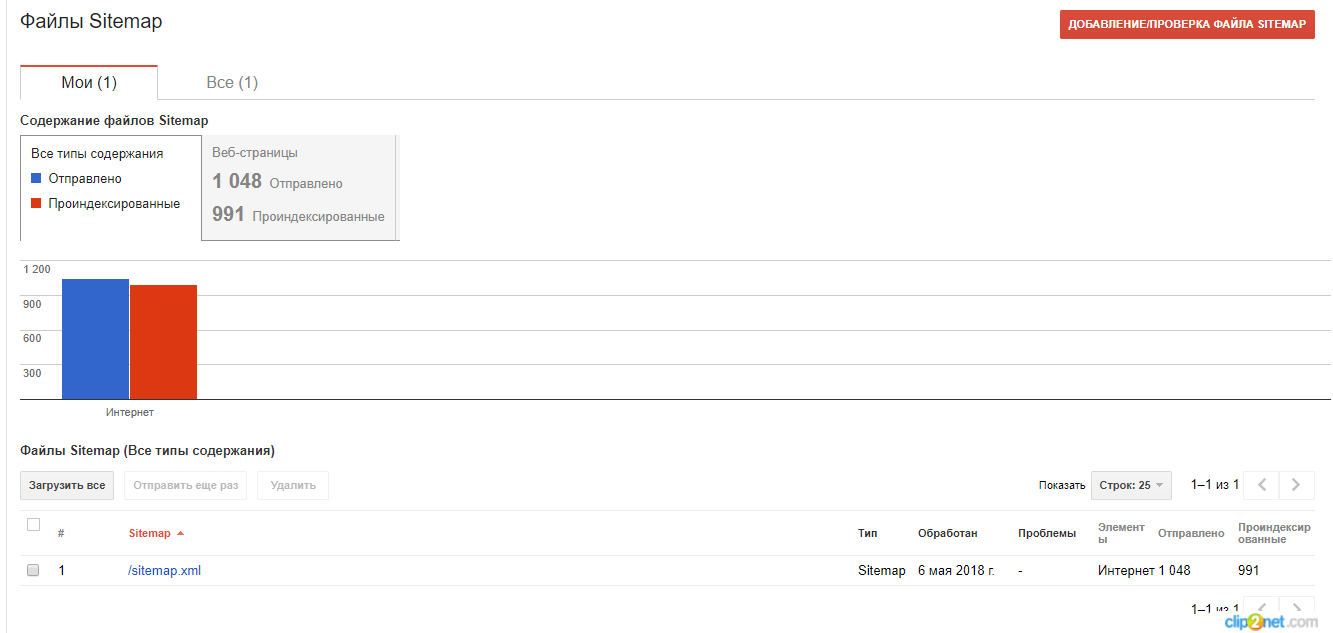

Sitemap

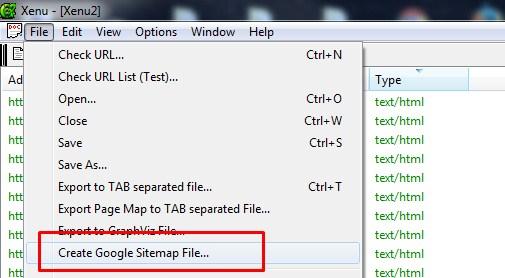

Убедитесь, что на сайте создана карта в формате XML (Sitemap) и добавлена в панель инструментов для вебмастеров Google и Яндекса.

Проверьте, не допущены ли в ней ошибки. Сделать это можно с помощью специальных инструментов поисковых систем Яндекс и Google.

Яндекс.Вебмастер → «Инструменты» → «Анализ файлов Sitemap»

Зайдите в Search Console → «Сканирование» → «Ошибки сканирования» → «файлы Sitemap»

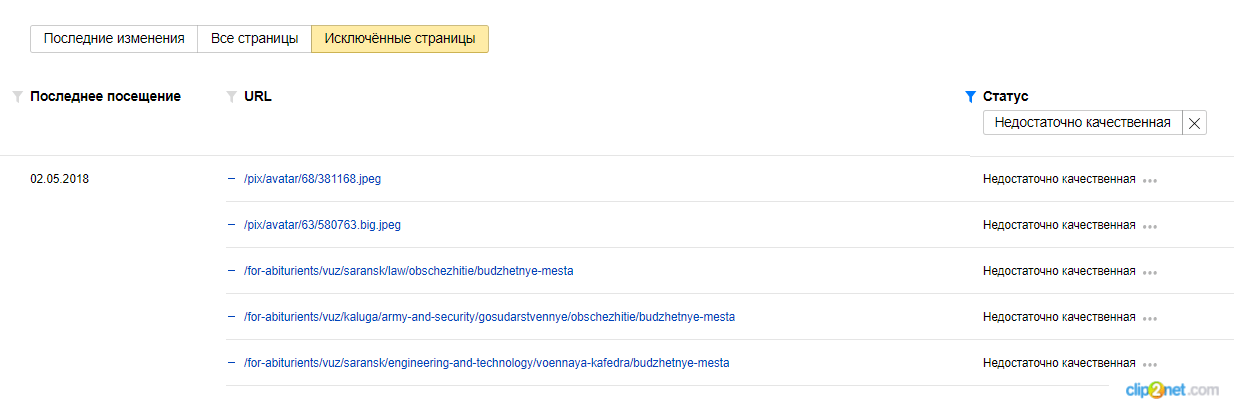

Недостаточно качественные страницы

Убедитесь, что на сайте нет удалённых низкокачественных страниц. Найти исключённые страницы можно с помощью Яндекс.Вебмастера и Google Search Console.

Яндекс.Вебмастер

Переходим в раздел «Индексирование» → «Страницы в поиске» → «Исключенные страницы», выбираем фильтр «Недостаточно качественные».

Google Search Console

Сигналом от Google о том, какие страницы были удалены из поиска из-за качества, можно считать «Отправленный URL возвращает ложную ошибку 404». В таких случаях нужно проанализировать страницы, убедиться, что они существуют, а не удалены (и просто ответ сервера некорректен).

Подробнее о мягкой 404 можно прочитать в нашем блоге.

Подробнее о страницах низкого качества написано в этой статье «Страницы низкого качества или как понять, что твой сайт “не очень”»

Адаптивный дизайн сайта

Доля мобильного трафика постоянно растёт, поэтому важно проверить адаптивность сайта под мобильные устройства.

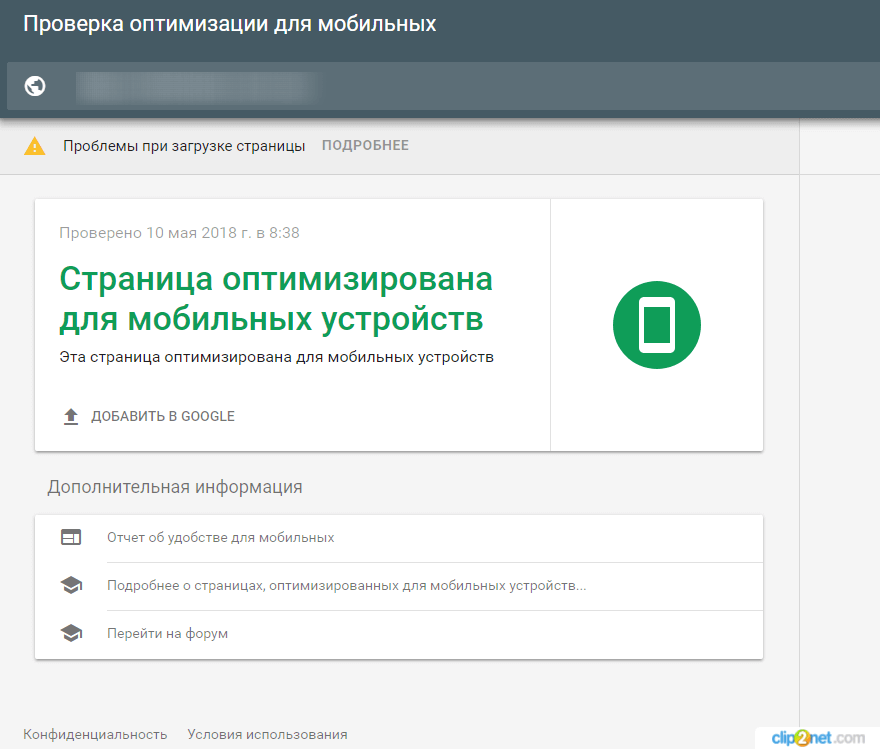

Для проверки можно использовать:

Инструмент позволяет проверить скорость загрузки страниц и даёт рекомендации, как эту скорость повысить.

Инструмент позволяет проанализировать, как выглядит сайт на смартфоне, скорость загрузки и отображения информации.

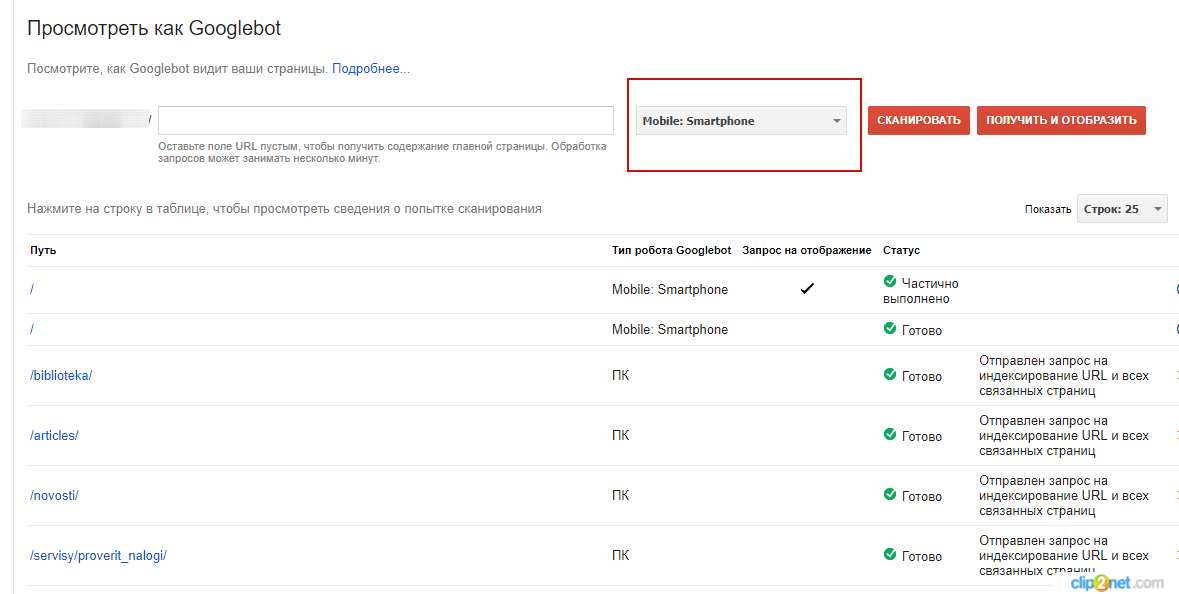

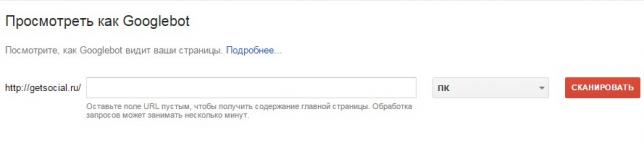

— Посмотреть как Googlebot (в панели Google Search Console).

Инструмент позволяет проанализировать отображение сайта на разных устройствах.

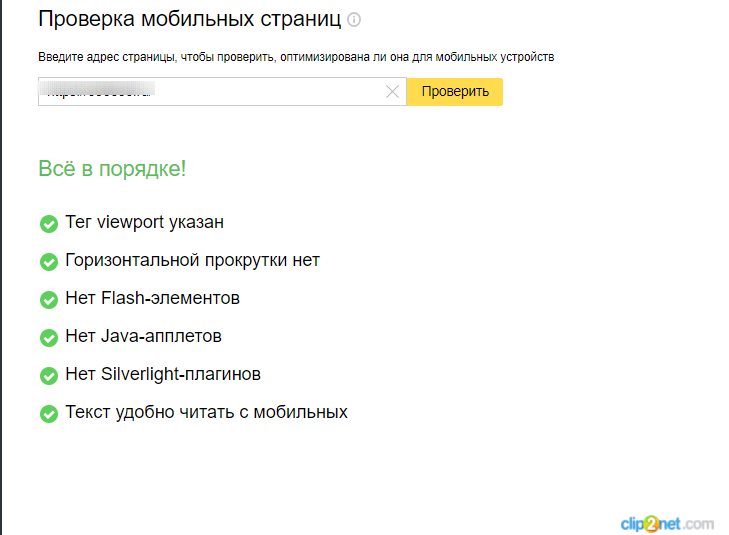

— Яндекс.Вебмастер → «Инструменты» → «Проверка мобильных страниц».

Инструмент позволяет проверить сайт на мобилопригодность.

О том, как влияет адаптивность сайта на ранжирование в ПС, как проверить и оптимизировать сайт под мобильные устройства, подробно описано в статье «Мобильная адаптация сайта – ответы на вопросы».

Заключение

В этой статье перечислены основные инструменты, которые понадобятся для проведения технического аудит сайта, и основные базовые параметры, которые нужно анализировать. Если вы не уверены в своих силах и знаниях, мы можем провести технический аудит вашего сайта и написать инструкции по решению проблемы.

Оптимизирую сайты с 2009 года. Люблю сложные кейсы, которые оказались не по зубам специалистам с других компаний. Делаю очень подробные аудиты.

Пишу статьи-инструкции на блог SiteClinic по SEO-инструментам и аналитике.

Любимая цитата: Чтобы добиться успеха, надо искренне любить то, чем вы занимаетесь.

Аудит сайта — первый этап работ по продвижению, и он закладывает основу, фундамент будущего результата. Качественный аудит предполагает сбор всех технических данных о сайте и его оптимизации под оценочные алгоритмы поисковых систем с последующим системным анализом. Это позволяет не только выявлять ошибки или уязвимости, но и формировать оптимальную стратегию продвижения. О том, какие для этого можно использовать инструменты, рассказывают специалисты веб-студии Яворского.

Обычно для этого используется чек-лист — список сервисов для анализа, а также обязательных пунктов, которые нужно проверить. Иногда для отдельного проекта этот список расширяют, внося дополнительные параметры для контроля. Аудит обычно проводят в два этапа: анализ с помощью готовых сервисов и проверка вручную.

Сервисов при таком анализе всегда несколько. Некоторые из них нужно устанавливать на компьютер, другие работают онлайн. Почти все они платные. Пользоваться каким-то одним инструментом для аудита не получится, потому что каждый из сервисов проверяет только часть параметров. Чтобы качественно оценить работу сайта, при аудите нужно охватить все возможные критерии, и это не всегда можно сделать с помощью исключительно автоматических инструментов. Поэтому мы обязательно проводим ручные проверки по отдельному чек-листу. Это позволяет выявить проблемы, на которые автоматический сервис может не среагировать.

Таких инструментов очень много. Их можно объединить в несколько групп.

Обычно это профессиональные инструменты, анализирующие отдельные «участки» работы сайта. Каждый из этих сервисов способен выявить только часть ошибок на сайте. Например:

предназначены для анализа индексации сайта поисковыми системами и выявления SEO ошибок на сайте. Например: кол-во страниц на сайте, битые ссылки, ошибки в прописывании мета тегов и т.д.

ориентирован на анализ семантического ядра, а Netpeak Spider ищет ошибки оптимизации.

Эти инструменты не требуют установки на компьютер и используются через браузер:

Все эти сервисы являются условно бесплатными: в ознакомительной версии их функционал ограничен, и они почти не дают полезной информации. При покупке платной лицензии появляется возможность полноценного анализа, но каждый из перечисленных инструментов охватывает только часть параметров. Например сервис Screaming Frog SEO охватывает достаточно много параметров сайта, но не дает информации по чистоте кода, ошибкам валидации. Не может оценить robots и sitemap.

Они используются как онлайн-инструменты — их не нужно скачивать и устанавливать на компьютер. В бесплатных версиях доступен только ознакомительный режим — с ограничением по функционалу, количеству выгружаемых страниц, возможности сохранения данных.

Среди таких сервисов наиболее известны:

Обычно такие сервисы применяются для проверки ограниченного количества параметров. Например, SERP Simulator оценивает мета-теги, а Brokenlinkcheck, как ясно из названия, проверяет сайт на битые ссылки.

Они применяются для проверки отдельных параметров. Анализ этих же характеристик может быть заявлен в функционале и других, более «универсальных» сервисов, но если важно качество проверки, лучше использовать специализированные инструменты:

Эти сервисы представлены в бесплатных версиях, но они пригодны только для ознакомления — провести полноценный анализ не удастся из-за ограничений функциональности.

Также широко используются

В дополнение к ним можно использовать встраиваемые в браузер расширения. Например, RDS Bar выполняет SEO-анализ страниц сайта и домена (но не проверяет при этом сайт на ошибки). Также это могут быть расширения для поиска битых ссылок, конкурентного анализа, анализа трафика, семантического анализа.

Не всегда даже платные сервисы и инструменты оказываются полезными. Иногда они работают как анкеты или опросники, собирающие данные сайта и предлагающие услуги по SEO-оптимизации. В других случаях сервисы проверяют минимум параметров, чтобы предложить платные услуги. Иногда в гайдах и рейтингах упоминаются инструменты, которые просто не работают, не поддерживаются или работают неправильно. Все это дополнительно усложняет аудит сайта, а иногда и делает его небезопасным.

Для автоматической проверки сайта важно использовать правильный набор инструментов и сервисов:

Ручные проверки дополняют автоматический анализ. Они помогают точнее оценить работу сайта, обнаружить уязвимости или слабые места. Для проверки некоторых параметров просто нет автоматических сервисов, а в других случаях контроль правильности работы сайта требует участия человека.

Ручная проверка выполняется по нескольким основным параметрам:

Наглядный пример, когда в коде страницы читается большее количество ключей, нежели на фронтенде

Обычно аудит выполняется по готовому чек-листу, в состав которого также включают:

Список параметров для проверки может зависеть от характеристик сайта (но обычно не менее 200), используемой CMS, особенностей функционала, юзабилити, целей и задач оптимизации, продвижения. Преимущество комплексного подхода, сочетающего автоматические проверки с ручным подходом, в том, что можно охватить максимум критериев и включить в их состав те параметры, которые важны для конкретного проекта.

Например, оцениваем параметр трафик на сайт

PR-CY показывает аж 2000 посетителей в месяц

Технический аудит сайта

Что такое технический SEO аудит сайта?

Технический аудит сайта — комплекс мероприятий, направленный на определение эффективности работы веб-сайта с технической точки зрения. Технический аудит включает в себя:

Аудит сайта необходимо выполнять регулярно не в зависимости от того, вносите ли вы какие изменения на сайте или нет. Битые ссылки, дубликаты и прочие проблемы могут появиться без вашего участия и совершенно в неподходящий момент. Обратите внимание, технически неисправных сайтов в ТОП 10 поисковых систем нет. Там только качественные ресурсы!

Различия между техническим аудитом сайта и другими видами аудита.

Технический аудит файла robots.txt.

Файл robots.txt содержит инструкции для Google, Yandex и других поисковых систем. Прежде чем начать сканирование сайта, поисковый робот анализирует инструкции в этом файле.

На этой вкладке в левой части расположена таблица с результатами аудита. Кликнув мышкой на каком-либо из параметров, в нижней части Вы увидите подсказку по этому параметру.

В правой части представлено содержимое файла robots.txt. Инструкции этого файла либо разрешают, либо запрещают поисковыми системам индексировать определённые странички или папки сайта.

Здесь же вверху есть вкладка «Запрещённые к индексации ресурсы». Здесь размещена таблица страничек и картинок, которые запрещены к индексации. Убедитесь, что в этом списке только те странички и картинки, которые не должны быть проиндексированы поисковыми системами. Иначе, следует внести правки в robots.txt.

Технический аудит сайта поисковые системы начинают с файла robots.txt.

Проверка карты сайта.

Карта сайта – это файл в формате XML, содержащий адреса всех тех страниц веб-сайта, которые должны быть просканированы поисковыми системами. Сейчас среди оптимизаторов нет единого мнения о важности этого файла. Тем не менее, лучше, всё-таки, его создать.

Вкладка карты сайта аналогична предыдущей вкладке «Файл robots.txt». В левой части перечень параметров, по которым проверяется карта сайта, в правой – само содержимое файла карты сайта.

Обратите внимание на вкладку «Рассогласования карты сайта и robots.txt». Иногда бывает так, что веб-мастер добавил страничку в карту сайта для того, чтобы страничка была проанализирована поисковыми системами, но при этом robots.txt запрещает индексацию этой странички. Отчёт на данной вкладке поможет Вам выявить такую ситуацию. Аудит сайта начинается с robots.txt, затем анализируется карта сайта, и только потом каждая отдельная страничка. Также обратите внимание на вкладку «Не найдено». На этой вкладке указаны все страницы, которые есть в карте сайта, но не были найдены при его сканировании. Таких не найденных страниц быть не должно. Если же они все-таки есть – это нужно исправить.

Немного о битых ссылках и дубликатах.

Проблема битых ссылок, пожалуй, одна из наиболее распространённых. Даже на авторитетных сайтах таковые встречаются. Нужно стараться вовремя выявлять и исправлять их, иначе про ТОП 10 можно забыть. Не будем сильно подробно останавливаться на битых ссылках, на эту тему написана отдельная статья, с которой можно ознакомиться здесь.

Дубликаты, как и битые ссылки, могут сильно повлиять на позиции сайта. Под дубликатами имеются ввиду странички сайта, имеющие одинаковый либо очень похожий контент. Программа Smart SEO Auditor не выполняет глубокого сравнительного анализа контента всех страниц, но она ищет повторяющиеся заголовки (Title, H1) и описания (Description).

Чтобы проверить наличие повторяющихся заголовков и описаний, перейдите на вкладку «Заголовок, описание, Н1, Н2». В правом нижнем углу вкладки показана общая информация о найденных дубликатах. В центральной части таблица с заголовками и описаниями для всех страниц сайта. Возле некоторых заголовков и описаний можно увидеть красный значок ошибки, который говорит о том, что данная строка повторяется. Для удобства анализа, рекомендуем использовать фильтры в верхней части окна и сортировку по советующему столбцу.

После завершения всех исправлений, обязательно выполните повторный технический аудит всего сайта. Подробнее о поиске дублей можно прочитать здесь.

Вкладка «Тех. аудит.»

В центральной части все страницы, которые были проанализированы. Ну а в нижней части детальная информация по выделенной страничке. Эта информация так же разбита на вкладки. Для удобства каждая вкладка имеет иконку в заголовке, которая указывает на наличие либо отсутствие ошибок. На первой вкладке необходимо убедиться, что кодировки заданы корректно и время ответа сервера в пределах допуска. На рисунке ниже с этими двумя критериями все в порядке, об этом нам говорят две зелёные галочки.

Обратите внимание на кнопку «Показать подсказку». Если смысл какого-либо SEO критерия Вам не понятен – нажмите на эту кнопку и Вы увидите подсказку.

На вкладке «HTML» необходимо обратить внимание на два критерия: «Текст / HTML», «Всего слов». Оба критерия являются косвенными SEO критериями, но все же их лучше не игнорировать.

Откроем вкладку «Размер». Здесь можно посмотреть размер всей веб-страницы, размер HTML документа, CSS/JavaScript файлов, изображений. Здесь необходимо убедиться в том, что выбранная страница не слишком «тяжелая», иначе это скажется на скорости загрузки и, как следствие, на позициях сайта в поиске.

Вкладка «Изображения». Здесь представлен список всех изображений, найденных на страничке. Суммарный вес всех изображения не должен превышать допуска. Так же стоит обратить внимание на размер каждого изображения отдельно. Большие картинки негативно влияют на скорость загрузки сайта. Ну и конечно же, битых изображений быть не должно.

Следующие две вкладки: «CSS файлы» и «JS файлы». Они организованы аналогично, поэтому рассмотрим их вместе. Здесь нужно убедиться в том, что количество файлов не слишком велико (не более 10), так же суммарный размер должен быть в пределах допуска.

О последняя вкладка «HTTP заголовок ответа». Этот заголовок не имеет отношения к SEO, но, очень часто, могут возникать вопросы, ответы на которые могут содержаться в HTTP заголовке.

Рассмотрим вкладки «CSS файлы» и «JS файлы», расположенные вверху. На этих вкладках можно увидеть полный список всех CSS и JavaScript файлов, найденных на сайте.

Здесь можно проверить, какие CSS/JavaScript файлы используются на сайте, какие страницы их используют, размеры файлов, коды ответа сервера. Здесь стоит убедиться, что нет битых ссылок, нет запрещённых для индексации файлов и нет слишком больших файлов. На этом технический аудит сайта завершается. Ещё раз хотим напомнить – проверять сайт необходимо регулярно, ошибки могут появляться не зависимо от вас.

SEO-аудит сайта самостоятельно: технический анализ и проверка внешних факторов

Часть 2 руководства по SEO-аудиту

Продолжаем разбирать особенности аудита сайтов. В первой части мы рассматривали структуру и контент сайта, а сегодня по плану технический аудит и проверка внешних факторов.

Для проведения технического аудита будут полезны следующие инструменты:

Технический аудит

Robots.txt — служебный файл, который содержит информацию для поисковых роботов. Должен быть доступен по адресу site.ru/robots.txt. Если этот файл отсутствует на сайте, то необходимо его создать.

В robots.txt можно указать следующую информацию для поисковых роботов: какие разделы сайта можно индексировать, а какие нет, главное зеркало, путь к карте сайта и т.д. Подробнее про настройку можно почитать в Помощи от Яндекса.

Необходимо убедиться, что в robots.txt закрыты от индексации серверные логи, админ-панель сайта, корзина интернет-магазина, другие технические разделы. Но обратите внимание, чтобы были открыты для ботов поисковиков скрипты сайта и CSS.

Пять проблем, с которыми сталкиваются руководители во время найма, и как их решать

Читайте колонку Марины Хадиной, директора по развитию Talantix — облачной CRM-системы для найма от hh.ru.

Проверить, какие разделы и страницы робот будет индексировать, а какие нет, можно, например, в кабинете Вебмастера Яндекса:

В Вебмастере Яндекса проверьте выбрано ли главное зеркало сайта. Укажите основной домен для Яндекса в robots.txt, воспользовавшись директивой Host. Например: Host: site.ru

При проведении технического аудита, необходимо замерить скорость загрузки страниц сайта. Например, в браузере Chrome можно быстро посмотреть скорость загрузки следующим образом F12→ Network→Doc→Time. Хороший результат — скорость загрузки меньше 1 секунды.

Далее проверяем код сайта на отсутствие мусора: скрытого текста, закомментированных блоков, каких-либо невидимых в публичной части элементов. Бывали случаи, когда недобросовестные оптимизаторы размещали в коде клиентского сайта скрытые от глаза пользователя тексты спамного содержания. Из-за чего сайт терял позиции в поисковых системах. Поэтому проверьте свой сайт не только с позиции пользователя, но и взглянув на него “глазами поискового робота”.

В Google Search Console можно посмотреть на сайт, как Googlebot:

Проверка URL-ов сайта может быть выполнена с помощью программ Xenu Link Sleuth или Screaming frog SEO spider.

Программа просканирует страницы вашего сайта и вы увидите все URL-ы, метатеги и заголовки, статусы страниц, сможете найти битые ссылки, редиректы, входящие и исходящие ссылки для страницы, посмотреть уровень вложенности страниц.

Для начала просмотрите URL-ы страниц. Будет лучше, если у сайта настроены ЧПУ (человекопонятные урлы). Убедитесь, что адреса страниц постоянные, а движок сайта не генерирует дубли страниц.

программа Screaming frog

С помощью этих программ вы сможете найти страницы с ошибкой 404 и битые ссылки. Их нужно устранять, чтобы пользователь попадал в нужный ему раздел, а не на страницу ошибки.

Что касается самой страницы 404 ошибки, то она должна быть оформлена, чтобы помочь пользователю сориентироваться, если уж он на неё попал. Обычно на ней размещают объяснение, что страницы с таким адресом нет и предлагают воспользоваться поиском по сайту, перейти на главную страницу или в основные разделы сайта.

Если по каким-то причинам меняют URL-ы сайта, то чтобы не возникало большое количество 404 ошибок, настройте редиректы со старых адресов на новые.

Проверьте наличие корректного sitemap. Многие движки сайтов позволяют настроить сайтмап, который будет автоматически обновляться, при внесении изменений на сайт (например, добавлении новых страниц). Подробно про карту сайта можно почитать здесь. Ссылку на sitemap укажите в файле robots:

Sitemap: http://site.ru/sitemap.xml

Сгенерировать карту сайта помогают программы Xenu и в SEO frog:

Программа Screaming frog может сделать sitemap с учетом файла robots.txt, чтобы не включать в него разделы сайта, которые вы закрыли для индексации.

Анализ внешних факторов

Аудит внешних факторов прежде всего включает в себя проверку обратных ссылок сайта.

Зачем нужен анализ бэклинков? Ссылки — один из важных факторов ранжирования сайта. И если сайт существует не первый день, то он скорее всего имеет ссылочную массу. Указанные выше сервисы: Majestic SEO, Ahrefs, MegaIndex.com — помогут с аудитом бэклинков.

Что нужно учесть при аудите?

1. количество входящих ссылок

2. анкор-лист

3. типы ссылок

4. типы и траст доноров

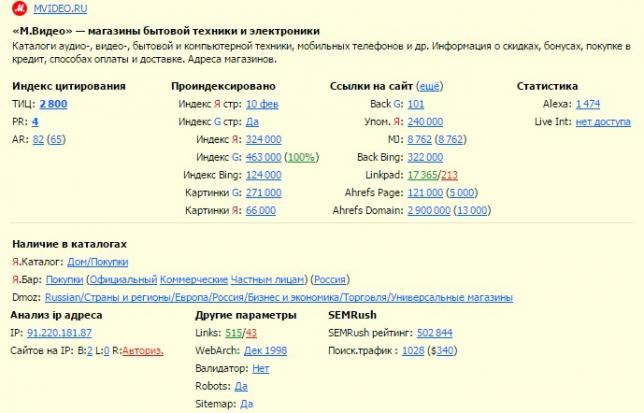

скриншот из системы MegaIndex.com

Количество обратных ссылок может быть разным, но если на ваш ресурс ведут сотни и тысячи бэклинков, то обязательно следует учесть рекомендации ниже.

Основные требования поисковых систем к ссылочному профилю сайта:

Расширение покажет основные данные по сайту: количество проиндексированных страниц, количество входящих и исходящих ссылок по Linkpad, ТИЦ (и наложен ли на сайт фильтр АГС), PR, наличие сайта в каталогах, дата вебархива и т.д.

Социальные факторы тоже должны быть учтены при проведении аудита. Посмотрите упоминания сайта в социальных сетях при помощи поиска Яндекс Блоги.

Одни из важных социальных факторов:

Поведенческие факторы

При помощи ЯндексМетрики и Google Analytics оцените поведение пользователей на сайте.

Что нужно учесть при анализе поведенческих факторов: