Технология deepfake что такое

Дипфейки: кому и зачем они нужны

Дипфейк (deepfake) – производная от «глубокого обучения» и «подделки»; штука, про которую сегодня большинство говорит с опаской. Само название как бы кричит: «Я зло!». А наша гипотеза в том, что это технология с огромнейшим позитивным потенциалом, которая пока используется в основном как игрушка в руках неразумного человека. Что это и как на самом деле? Давайте разбираться.

Дипфейки используют технологии искусственного интеллекта для синтеза изображений, в результате чего один персонаж как бы накладывается на другого и получается «комбо»: оживает Мона Лиза или Терминатором становится Бред Питт.

Эта технология позволяет легко манипулировать аудио- и видеоконтентом, а по мере того, как она развивается, разобраться, где правда, а где фейк – становится всё сложнее. Так в прогремевшем на весь интернет видео Барак Обама критикует Дональда Трампа, называя его «полным провалом». В США считается, что дипфейки представляют угрозу национальной безопасности. В Калифорнии некоторые виды дипфейков даже запретили законодательно.

Чаще всего дипфейки создаются с помощью генеративно-состязательной сети (GAN), в ней 2 системы: генератор и дискриминатор. Они работают как пара студентов в университетской микрогруппе: один предлагает идеи, другой их критикует. Генератор создаёт изображения, а обученный на реальных фотографиях дискриминатор подсказывает, что нужно исправить.

Заметим, что технология постоянно развивается. Так, например, алгоритм BigGAN от Google и NVIDIA позволяет не просто воссоздавать, а создавать лица несуществующих людей, которые невозможно отличить от настоящих.

Недавно разработчики из Samsung и Сколково представили алгоритм на основе BigGAN, который позволил «оживить» Мону Лизу, то есть для (относительно) хорошего результата нейросети достаточно одного кадра. Нейросеть работает лучше всего, если дать ей несколько изображений человека, снятых под разными углами.

Сейчас на рынке десятки приложений, с помощью которых любой может сделать дипфейк, самые известные – Zao, DeepFaceLab, Deepfakes web β.

Конкурентные преимущества приложений похожи на классический треугольник «цена-качество-скорость»:

– Скорость. Одни выполняют конверсию за секунды, другим нужны часы.

– Необходимое количество исходного материала. Некоторым достаточно одной фотографии.

– Точность итогового результата. Обычно чем больше исходного материала и дольше идёт процесс анализа, тем точнее получается результат.

Год назад NVIDIA представила нейросеть, которая может превращать скетчи в реальные изображения. Технологию назвали GauGAN в честь Поля Гогена. Такую штуку можно использовать в архитектуре, дизайне, создании игр, да где угодно.

Технологию, которая лежит в основе дипфейков, можно использовать и в киноиндустрии, рекламе или при реконструкции исторических событий. Например, с её помощью была сделана социальная реклама, в которой Дэвит Бэкхем рассказывает об опасности малярии на 9и языках.

Музей Сальвадора Дали во Флориде «оживил» художника с помощью всё той же технологии. В результате зрители могли пообщаться с Дали, послушать его истории и даже получить совместное селфи. Для этого потребовалось 6000 фотографий Дали, 1000 часов машинного обучения и 145 видео с актером похожих пропорций, а ещё горы интервью и писем художника, чтобы воспроизвести голос, акцент и манеру речи.

Кстати, алгоритм GAN предлагается использовать и в астрофизике для того, чтобы избавляться от помех и шумов при съёмке космических объектов и получать качественные изображения.

Если вы тоже считаете, что человеческий интеллект создан для творчества, а машинный – для работы, присоединяйтесь к нам на YouTube или в Facebook!

6 лучших Deepfake приложений и инструментов в 2021 году

Различные методы манипулирования изображениями были введены в 19 веке и позднее применялись к кинофильмам. Эти методы быстро улучшились с цифровым видео.

В начале 1990-х годов исследователи из академических институтов разработали технологию Deepfake, которая впоследствии была доработана разработчиками в онлайн-сообществах. В последнее время подделки Deepfake привлекают большое внимание за их использование в финансовых махинациях, розыгрышах и фальшивых новостях.

Это заставило правительство и промышленность выявлять и ограничивать их незаконное использование. Тем не менее технология имеет большой потенциал, если ее правильно использовать.

Что такое технология Deepfake?

Deepfakes относятся к манипулируемому визуальному контенту, генерируемому сложным искусственным интеллектом, который дает сфабрикованные изображения и звуки, которые кажутся реальными. В большинстве случаев, человек в существующем видео или изображении заменяется на чье-то подобие.

Хотя трудно создать хороший deepfake на обычном компьютере, есть много инструментов, доступных в интернете, чтобы помочь людям сделать достойные deepfakes. Технология все еще находится в зачаточном состоянии, поэтому не ожидайте идеального результата.

Мы тщательно собрали несколько хороших deepfake приложений и инструментов, которые не требуют высокого класса рабочего стола с мощными графическими картами (за исключением одного или двух). Вы можете использовать их как в исследовательских целях, так и просто для развлечения, но не нарушайте чью-либо частную жизнь.

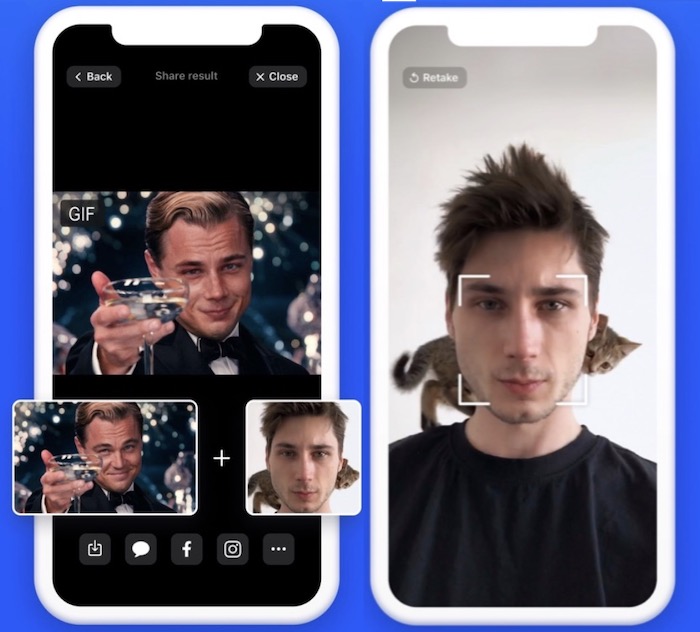

6. Doublicat

Платформа: Android / iOS

Цена: Бесплатно

Doublicat позволяет вам сделать селфи и поместить свое лицо на мем или GIF в своей библиотеке. Это займет около 5 секунд, чтобы ваше лицо было наложено на лицо Брэда Питта, Леонардо Ди Каприо или Тейлора Свифта.

Вы будете удивлены, увидев, насколько хорошо ваше наложенное лицо принимает те же выражения, что и оригинал. Вы можете переслать результаты своей семье и друзьям или опубликовать их в Instagram.

Вывод будет довольно странным, если будет много движений лица, но в целом это интересный эксперимент. По словам разработчиков приложения, само изображение удаляется с серверов сразу после его обработки. Однако при этом сохраняется представление черт лица.

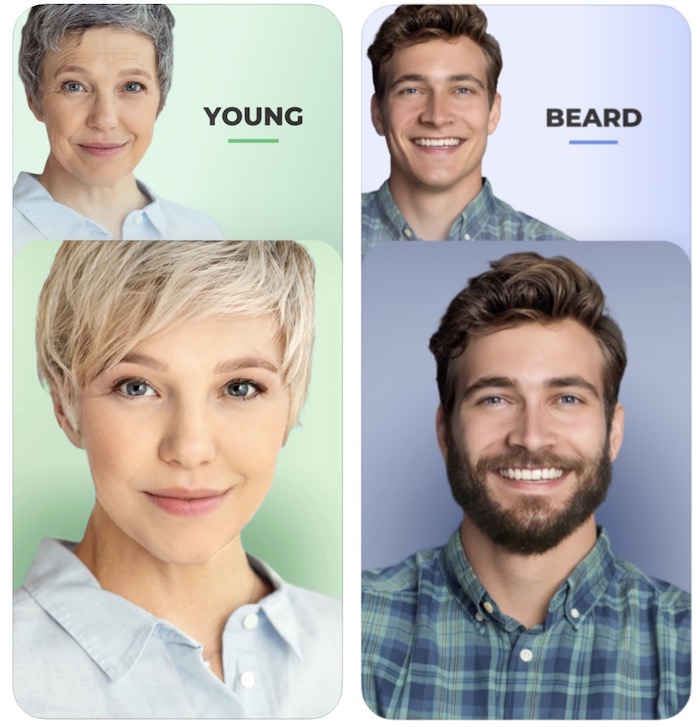

5. FaceApp

Платформа: Android / iOS

Цена: Бесплатно

FaceApp разработан российской компанией Wireless Lab. Он использует нейронные сети для генерации высокореалистичных преобразований лиц на фотографиях.

Приложение может преобразить ваше лицо, чтобы заставить его улыбаться, выглядеть старше, выглядеть моложе или просто смены пола, а также многих других захватывающих преобразований. Татуировки, виньетки, размытие объектива и наложение фона также являются частью FaceApp.

В 2018 году приложение привлекло много внимания со стороны трансгендерных и ЛГБТ-сообществ из-за его реалистичных преобразований гендерных изменений. Он также столкнулся с критикой как в социальных сетях, так и в прессе за конфиденциальность пользовательских данных.

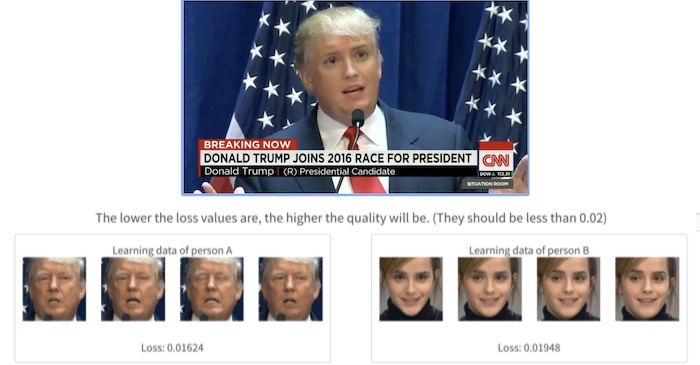

4. Deepfakes web β

С помощью этого инструмента вы можете создавать deepfake видео в интернете. Однако кривая обучения здесь немного больше, чем то, что вы найдете в других приложениях.

Вам нужно зарегистрироваться и загрузить свои видео. Все остальное происходит в облаке, где используются мощные графические процессоры. На изучение видео/изображений и смену лиц уходит почти 4 часа. Вы также можете использовать обученную модель, чтобы менять лица, что занимает около 30 минут.

Качество выходного видео зависит от значений «потерь»: чем ниже значения потерь (при обучении из загруженных видео), тем выше качество. И, конечно, только вы можете получить доступ к своим видео и учебным данным.

3. DeepFaceLab

Платформа: Windows

Цена: Бесплатный

DeepFaceLab является ведущим программным обеспечением для создания подделок. Она использует новые нейронные сети для замены лиц в видео. Она размещена на GitHub и породила бесчисленное множество видео в интернете.

По словам его разработчиков, более 95% глубоких подделок видео создаются с помощью DeepFaceLab. Его используют несколько популярных каналов YouTube, таких, как Ctrl Shift Face, iFake и Shamook.

DeepFaceLab прекрасно работает, но для его использования необходимы технические знания. Как только вы загрузите и разархивируете инструмент, вы увидите множество папок и ряд командных файлов. Существует папка с именем «workspace», которая содержит все обучающие модели, исходные видео и выходные данные. Инструмент работает с определенными именами и местоположениями файлов, чтобы пакетный файл мог функционировать.

2. FaceSwap

Платформа: Windows | MacOS | Linux

Цена: бесплатно

FaceSwap похож на DeepFaceLab, но предоставляет больше возможностей, лучшую документацию и лучшую онлайн-поддержку. И да, он также доступен на Mac и Linux.

Это инструмент с открытым исходным кодом, наполненный функциональностью для выполнения каждого шага процесса Deepfake, от импорта первоначального видео до создания финального видео Deepfake. Чтобы запустить этот инструмент, вам нужна мощная видеокарта, так как замена лица происходит невероятно медленно.

Работая на Python, Keras и Tensorflow, Faceswap имеет активное сообщество, поддерживающее и разрабатывающее программное обеспечение. Есть много учебников, которые помогут вам начать работу.

1. Zao

Платформа: Android | iOS

Цена: бесплатно

Технология глубокой подделки Zao позволяет вам модулировать голоса знаменитостей и накладывать свое лицо на тело актера в сцене.

Просто нажмите на одну фотографию и попробуйте тысячи модных причесок, одежды и макияжа. Приложение предоставляет вам множество видеоклипов, нарядов и буквально неограниченные возможности для изучения.

В 2019 году Zao за короткое время приобрел значительную популярность, позволив пользователям обмениваться лицами с любимыми актерами в коротких клипах из телепередач и фильмов. За месяц он стал самым загружаемым бесплатным приложением в Китае. С ростом популярности, его разработчики также столкнулись с критикой политики конфиденциальности приложения.

Это займет всего несколько секунд, чтобы поменять ваше лицо, но так как алгоритм в основном обучен на китайских лицах, это может выглядеть не так естественно, как вы ожидаете.

Тем не менее все эти инструменты демонстрируют, как быстро развивался базовый ИИ: то, что раньше требовало тысячи картинок, чтобы сделать достаточно убедительное глубокое поддельное видео, теперь требует только одного изображения и дает лучшие результаты.

Дипфейки и другие поддельные видео – как защитить себя?

Дипфейки: новые технологии обмана

Слово дипфейк (Deepfake) является составным и происходит от deep learning (глубинное обучение) и fake (фейк, подделка). Глубинное обучение – это сложный метод на базе искусственного интеллекта, который использует многоуровневые алгоритмы машинного обучения для извлечения все более сложных характеристик из необработанных входных данных. При этом ИИ способен обучаться на неструктурированных данных – таких как изображения лиц. Например, ИИ может собрать данные о движениях вашего тела.

Затем эти данные могут быть обработаны для создания дипфейк-видео при помощи так называемой генеративно-состязательной сети (Generative Adversarial Network, или GAN). Это еще одна специализированная система машинного обучения. В ней задействовано две нейросети, которые состязаются друг с другом, изучая характеристики учебных наборов данных (например, фотографий лиц) и создавая новые данные на базе этих характеристик (то есть новые «фотографии»).

Поскольку такая сеть постоянно сверяет создаваемые образцы с исходным учебным набором, поддельные изображения выглядят все более и более правдоподобно. Именно поэтому угроза, которую представляют дипфейки, постоянно растет. Кроме того, сети GAN могут создавать и другие поддельные данные помимо фотографий и видео. Например, дипфейк-технологии могут использоваться для имитации голоса.

Примеры дипфейков

Качественные дипфейки с участием знаменитостей найти несложно. Один из примеров – фейковое видео, выложенное актером Джорданом Пилом. Он записал небольшую речь голосом Барака Обамы, которая затем была совмещена с видеосъемкой реального выступления этого политика. Затем Пил продемонстрировал, как выглядят обе составляющие этого видео, и призвал своих зрителей критически относиться ко всему, что они видят.

Видео с руководителем Facebook Марком Цукербергом, в котором тот якобы говорит о том, как Facebook «управляет будущим» с помощью украденных данных пользователей, появилось в Instagram. На оригинальном видео запечатлена его речь в связи со скандалом о «русском следе» в выборах президента США – для создания фейка оказалось достаточно фрагмента длиной всего в 21 секунду. Однако голос Цукерберга был сымитирован не так хорошо, как в пародии Джордана Пила на Обаму, и фальшивку было легко распознать.

Впрочем, даже менее качественные подделки могут вызвать живой отклик. Видео с «пьяной» Нэнси Пелоси, спикером Палаты представителей США, набрало миллионы просмотров на YouTube – а это был всего лишь фейк, сделанный с помощью замедления реального видео, чтобы создать видимость невнятной речи. Кроме того, немало известных женщин внезапно обнаружили себя в роли порнозвезд – их лица были вмонтированы в порнографические ролики и изображения.

Мошенничество и шантаж с использованием дипфейков

Дипфейк-видео неоднократно использовались в политических целях, а также как способ мести. Однако сейчас к этим технологиям все чаще стали прибегать для шантажа и проворачивания крупных афер.

У генерального директора британской энергетической компании мошенники смогли выманить 220 000 евро с помощью дипфейковой имитации голоса руководителя головной компании, якобы запросившего срочно перевести указанную сумму. Подмена была настолько натуралистичной, что обманутый директор не стал перепроверять информацию, хотя средства переводились не в головной офис, а на сторонний счет. Только когда «босс» запросил еще один трансфер, его собеседник заподозрил неладное, но переведенные деньги уже бесследно исчезли.

Во Франции недавно прогремела афера, в которой, правда, технология дипфейков не использовалась, – мошенник по имени Жильбер Шикли выдавал себя за министра иностранных дел Франции Жана-Ива Ле Дриана, с большой точностью воссоздав не только его внешность, но и обстановку рабочего кабинета. Аферист от имени министра обращался к состоятельным частным лицам и руководителям компаний с просьбой выделить средства на выкуп французских граждан, оказавшихся в заложниках террористов в Сирии. Таким образом ему удалось выманить несколько миллионов евро. Сейчас это дело рассматривается в суде.

Авторы дипфейков могут шантажировать руководителей крупных компаний, угрожая опубликовать фейковое видео, способное подорвать их репутацию, если те не заплатят отступные. Также мошенники могут, например, проникнуть в вашу сеть, сымитировав звонок от IT-директора и обманом заставив сотрудников предоставить пароли и привилегии доступа, после чего ваши конфиденциальные данные окажутся в полном распоряжении хакеров.

Фейковые порноролики уже использовались с целью шантажа женщин-репортеров и журналисток, как, например, произошло в Индии с Раной Айюб, которая занималась разоблачением злоупотреблений властью. Технологии производства дипфейков дешевеют, так что можно прогнозировать рост их использования в целях шантажа и мошенничества.

h2>Как защититься от дипфейков?

Проблему дипфейков уже пытаются начать решать на законодательном уровне. Так, в штате Калифорния в прошлом году было принято два закона, ограничивающих использование дипфейков: законопроект AB-602 запретил использование технологий синтеза изображений человека для изготовления порнографического контента без согласия изображаемых, а AB-730 – подделку изображений кандидатов на государственные посты в течение 60 дней перед выборами.

Но окажутся ли эти меры достаточными? К счастью, компании в сфере безопасности постоянно разрабатывают все более совершенные алгоритмы распознавания. Они анализируют видеоизображения и замечают незначительные искажения, возникающие в процессе создания фальшивки. Например, современные генераторы дипфейков моделируют двумерное лицо, а затем искажают его для встраивания в трехмерную перспективу видеоролика. По тому, куда направлен нос, легко распознать подделку.

Пока что технологии создания дипфейков еще недостаточно совершенны, и признаки подделки зачастую видны невооруженным глазом. Обращайте внимание на следующие характерные признаки:

Однако по мере совершенствования технологий ваши глаза все реже будут распознавать обман – а вот хорошее защитное решение обмануть будет куда сложнее.

Уникальные антифейковые технологии

Некоторые развивающиеся технологии уже помогают создателям видеоконтента защищать его аутентичность. С помощью специального шифровального алгоритма в видеопоток с определенными интервалами встраиваются хеши; если видео будет изменено, хеши также изменятся. Создавать цифровые сигнатуры для видео также можно, используя ИИ и блокчейн. Это похоже на защиту документов водяными знаками; в случае с видео, правда, трудности заключаются в том, что хеши должны оставаться неизменными при сжатии видеопотока различными кодеками.

Еще один способ борьбы с дипфейками – использовать программу, вставляющую в видеоконтент специальные цифровые артефакты, маскирующие группы пикселей, по которым ориентируются программы для распознавания лиц. Этот прием замедляет работу дипфейк-алгоритмов, и в результате качество подделки будет более низким, что, в свою очередь, снизит вероятность успешного использования дипфейка.

Лучшая защита – соблюдение правил безопасности

Технологии – не единственный способ защититься от дипфейк-видео. В борьбе с ними весьма эффективны даже базовые правила безопасности.

Так, например, встраивание автоматических проверок во все процессы, связанные с перечислением денежных средств, позволило бы предотвратить множество мошеннических действий, в том числе и с использованием дипфейков. Также вы можете:

Помните, что, если хакеры начнут активно использовать дипфейки для проникновения в домашние и корпоративные сети, соблюдение базовых правил кибербезопасности станет важнейшим фактором в минимизации рисков:

Как будут развиваться дипфейки?

Дипфейки эволюционируют угрожающими темпами. Еще два года назад подделки легко было отличить по низкому качеству передачи движения; кроме того, люди в таких видео практически никогда не моргали. Однако технологии не стоят на месте, и дипфейки последнего поколения выполнены заметно более качественно.

По приблизительным оценкам, сейчас по Сети гуляет более 15 000 дипфейк-видео. Некоторые из них шуточные, но есть и такие, которые создавались для манипуляций общественным сознанием. Сейчас изготовление нового дипфейка занимает от силы пару дней, так что вскоре их может стать намного больше.

Дипфейки: что это за технология и почему она опасна

Слово deepfake появилось несколько лет назад. Оно объединяет в себе два понятия: глубокое обучение (deep learning), то есть обучение нейросетей, и подделку (fake). Технология дипфейков заключается в синтезе ИИ человеческих изображений: алгоритм объединяет несколько фото, на которых человек изображен с разным выражением лица, и делает из них видео. При этом ИИ анализирует большое количество снимков и учится тому, как может выглядеть и двигаться конкретный человек. Об этом пишет американское издание Forbes.

С распространением дипфейков появились случаи «дискредитации» публичных личностей, чьих изображений много в открытом доступе. Например, весной 2019 года в Сети было опубликовано дипфейк-видео со спикером палаты представителей конгресса США Нэнси Пелоси. Автор ролика с помощью ИИ изменил речь Пелоси так, что она плохо выговаривала слова, и пользователи, посмотревшие видео, посчитали, что политик пьяна. Ситуация вылилась в громкий скандал, и лишь спустя некоторое время было доказано, что речь Пелоси была сгенерирована ИИ.

Этот дипфейк был сделан достаточно просто. Но есть и сложные алгоритмы. Они не просто меняют тембр голоса или замедляют речь, а генерируют такие видео, на которых человек делает то, чего никогда не совершал, или говорит то, чего никогда не говорил. Со временем дипфейки будут становиться все более реалистичными, пишет американское издание Forbes. Уже сейчас технология претендует на то, чтобы влиять на политику, а в дальнейшем такие видео и вовсе смогут стать угрозой национальной безопасности.

Что такое deepfake и чем опасна эта технология?

IT-компания DAR и Informburo.kz в проекте “Понятно о технологиях” – о том, что такое deepfake и как отличить поддельные фотографии и видео от настоящих.

Помните сцену из легендарного фильма Стэнли Кубрика «Сияние», когда обезумевший писатель Джек Торренс (Джек Николсон), прорубает топором дверь, пытаясь попасть в ванную, где спрятались его сын и жена? Он просовывает голову внутрь и, скалясь, кричит: «А вот и Джонни!».

Сцена из фильма стала культовой, а пару месяцев назад в сети появились ролики, где вместо лица Николсона при помощи алгоритма машинного обучения было «подрисовано» лицо Джима Керри. Актёр двигался, разговаривал и точь-в-точь повторял мимику персонажа Николсона.

Подмена лиц в видео быстро набрала обороты и получила название deepfake (конкатенация слов «глубинное обучение» (англ. Deep learning) и «подделка» (англ. Fake). И технология так и осталась бы забавой, но вскоре в Сети стали появляться ролики с политиками. Как оказалось, чехарда с «подрисовыванием» лиц представляет куда большую угрозу, ведь злоумышленники вполне могут использовать такой подход в информационных войнах или мести, тем более что отличить deep fakes от реальной картинки становится все сложнее.

Что такое deepfake?

Искусственный интеллект deepfake использует синтез человеческого изображения – объединяет несколько картинок, на которых человек запечатлен с разных ракурсов и с разным выражением лица, и делает из них видео. Анализируя фотографии, специальный алгоритм «учится» тому, как выглядит и может двигаться человек.

Работают две нейросети. Первая генерирует образцы изображения, а вторая отвечает за то, чтобы отличать настоящие образцы от поддельных. Технологию можно сравнить с работой двух фальшивомонетчиков, один из которых подделывает купюры, а второй пытается отличить эти подделки от оригиналов. В случае если второй обнаруживает подделку, изображение отсылается первому, который улучшает свою работу, предлагая более реалистичную подделку.

Сервисы deepfake работают при помощи открытых алгоритмов машинного обучения и библиотек, за счёт чего нейросеть может не только обучиться, но и достичь «почти человеческого» качества. Нейросеть получает изображения из библиотеки и «учится» при помощи роликов на том же YouTube. Искусственный интеллект тем временем сопоставляет фрагменты исходных портретов с тем, что есть на видео, и в итоге мы получаем максимально правдоподобную картинку.

Публикация от Илона Нейро ТП (@neural_tp) 25 Авг 2019 в 9:27 PDT

Поддельные видеоролики стали появляться в 2017-м году, когда один из пользователей социального сервиса Reddit с ником Deepfakes разместил у себя на страничке видео для взрослых, где вместо настоящего лица актрисы было «подрисовано» лицо исполнительницы роли Чудо-женщины Галь Гадот. Позже подобная технология также была использована для ролика, где экс-президент США Барак Обама нецензурно выражался и оскорблял Дональда Трампа. Лицо экс-президента просто наложили на лицо актёра Джордана Пила. Получилось правдоподобно.

В чём тут опасность?

С распространением deep fake появилась опасность дискредитации любого пользователя, фото которого есть в сети. Первыми под огонь попали публичные личности, изображений которых достаточно много в открытом доступе. Например, лицо актера Николаса Кейджа давно стало мемом, а сам он известен неразборчивостью в выборе ролей. Благодаря deep fake лицо Николаса Кейджа поместили практически во все эпизоды известных фильмов. Например, он стал Лоис Лейн из «Человека из стали»:

Учитывая количество фото, которые мы заливаем в социальные сети, недостатка в материале для deep fake нет. Проблема в том, что в будущем пользователи, которые не смогут доказать, что их не было на определённом видео, может, например, грозить тюремный срок.

По мнению Адиля Жалилова, руководителя factсheck.kz, в зависимости от контента такие видео могут быть как безобидными, так катастрофически опасными.

«Предположим, что, учитывая напряжённые отношения между этносами, религиозными группами, кто-то зальет в социальные сети видео, где представитель той или иной группы высказывает оскорбительные мнения или осуществляет действия, которые могут быть восприняты как оскорбление», – говорит он.

По его словам, если население будет не в курсе о возможностях и вообще о существовании deep fakes, то любое такое поддельное видео с провокационным контентом может «вложить в уста» любому политику или представителю какого-либо этноса любой месседж. Это может породить деструктивный импульс и спровоцировать конфликты. Любая попытка властей реагировать, объяснить технологию deep fakes постфактум будет запоздалой в такой ситуации.

Можно ли распознать deepfake?

Видео с применением deepfake выглядят убедительно только в течение пары-тройки секунд, но они (во всяком случае, пока) далеки от того, чтобы обмануть пользователей.

Если присмотреться к таким роликам внимательней, то можно заметить, что, например, «подрисованные» лица на видео не моргают.

Эффект постоянно открытых глаз связан с недостатками процесса создания таких роликов. Дело в том, что среди картинок, по которым обычно учится нейросеть, не так много (на самом деле их нет вообще) фотографий с закрытыми глазами. Пользователи вряд ли хранят или выкладывают в сеть неудачные селфи, на которых они моргают.

Адиль Жалилов отмечает, что в перспективе распознавать deep fakes можно будет путём анализа движения глаз и амплитуды моргания.

«Предполагаю, что найдутся и другие методы распознавания поддельных видео. И очень важно, чтобы эти методы были простыми и прикладными, доступными для общества. Также важно всем государствам активно развивать и поддерживать фактчекинг, специализирующийся на борьбе с дезинформацией, а также медиаграмотность, куда включать обучение всего населения в том числе по распознаванию поддельных изображений и видео», – говорит Жалилов.

Чтобы распознать deepfake, учёные из Университета Олбани провели эксперимент, в котором выявили, что в среднем люди моргают 17 раз в минуту. Эта цифра увеличивается до 26 раз во время разговора, и падает до 4,5 раз во время чтения. Эти же учёные предложили свой метод распознавания фейковых видеороликов, объединив две нейронные сети, для того чтобы более эффективно распознавать ненастоящие лица. Как выяснилось, нейронные сети часто упускают спонтанные и непроизвольные физиологические действия. Например, дыхание во время речи или движение глаз.

«Так как многие из политиков, вероятно, читают текст своей речи, когда их снимают. Когда спикер на видео не моргает вообще, легко определить, что такие кадры являются фейком», – говорит профессор Люй, возглавивший исследование Университета Олбани.

Профессор отмечает, что стандарты проверки доказательств deep fake должны развиваться параллельно улучшению поддельных видео, иначе однажды мы вообще не сможем доверять видеоконтенту.