Теория вероятности что такое гипотеза

Формула полной вероятности. Вероятность гипотез

Формула полной вероятности. Вероятность гипотез

Формула полной вероятности. Вероятность гипотез

Формула полной вероятности

Вероятность гипотез. Формула Байеса

Для этого используем теорему умножения.

$P(AB_1)=P(A)\cdot P_A(B_1)=P(B_1)\cdot P_ < B_ < 1 >> (A)$

$P_A ( < B_1 >)=\frac < P( < B_1 >)\cdot P_ < B_1 >( A ) > < P( A ) >$, Формула Байеса

Сделаем два предположения, две гипотезы:

Далее:

Функции k-значной логики. Элементарные функции. Лемма об аналоге правила де Моргана

Функции 2-значной логики. Лемма о числе функций. Элементарные функции 1-ой и 2-х переменных

Теорема о предполных классах

Гармонические поля

Вычисление двойного интеграла. Двукратный интеграл

Теорема об аналоге СДНФ в Pk

Вычисление объёмов

Соленоидальное векторное поле

Механические приложения тройного интеграла

Теорема Остроградского

СДНФ. Теорема о представлении в виде СДНФ. Построение СДНФ по таблице

Дифференциальные характеристики векторного поля

Вычисление площади поверхности

Определение тройного интеграла. Теорема существования тройного интеграла

Теория вероятностей, формулы и примеры

Тема непростая, но если вы собираетесь поступать на факультет, где нужны базовые знания высшей математики, освоить материал — must have. Тем более, все формулы по теории вероятности пригодятся не только в универе, но и при решении 4 задания на ЕГЭ. Начнем!

Основные понятия

Французские математики Блез Паскаль и Пьер Ферма анализировали азартные игры и исследовали прогнозы выигрыша. Тогда они заметили первые закономерности случайных событий на примере бросания костей и сформулировали теорию вероятностей.

Когда мы кидаем монетку, то не можем точно сказать, что выпадет: орел или решка.

Но если подкидывать монету много раз — окажется, что каждая сторона выпадает примерно равное количество раз. Из чего можно сформулировать вероятность: 50% на 50%, что выпадет «орел» или «решка».

Теория вероятностей — это раздел математики, который изучает закономерности случайных явлений: случайные события, случайные величины, их свойства и операции над ними.

Вероятность — это степень возможности, что какое-то событие произойдет. Если у нас больше оснований полагать, что что-то скорее произойдет, чем нет — такое событие называют вероятным.

Ну, скажем, смотрим на тучи и понимаем, что дождь — вполне себе вероятное событие. А если светит яркое солнце, то дождь — маловероятное или невероятное событие.

Случайная величина — это величина, которая в результате испытания может принять то или иное значение, причем неизвестно заранее, какое именно. Случайные величины можно разделить на две категории:

Вероятностное пространство — это математическая модель случайного эксперимента (опыта). Вероятностное пространство содержит в себе всю информацию о свойствах случайного эксперимента, которая нужна, чтобы проанализировать его через теорию вероятностей.

Формулы по теории вероятности

Теория вероятности изучает события и их вероятности. Если событие сложное, то его можно разбить на простые составные части — так легче и быстрее найти их вероятности. Рассмотрим основные формулы теории вероятности.

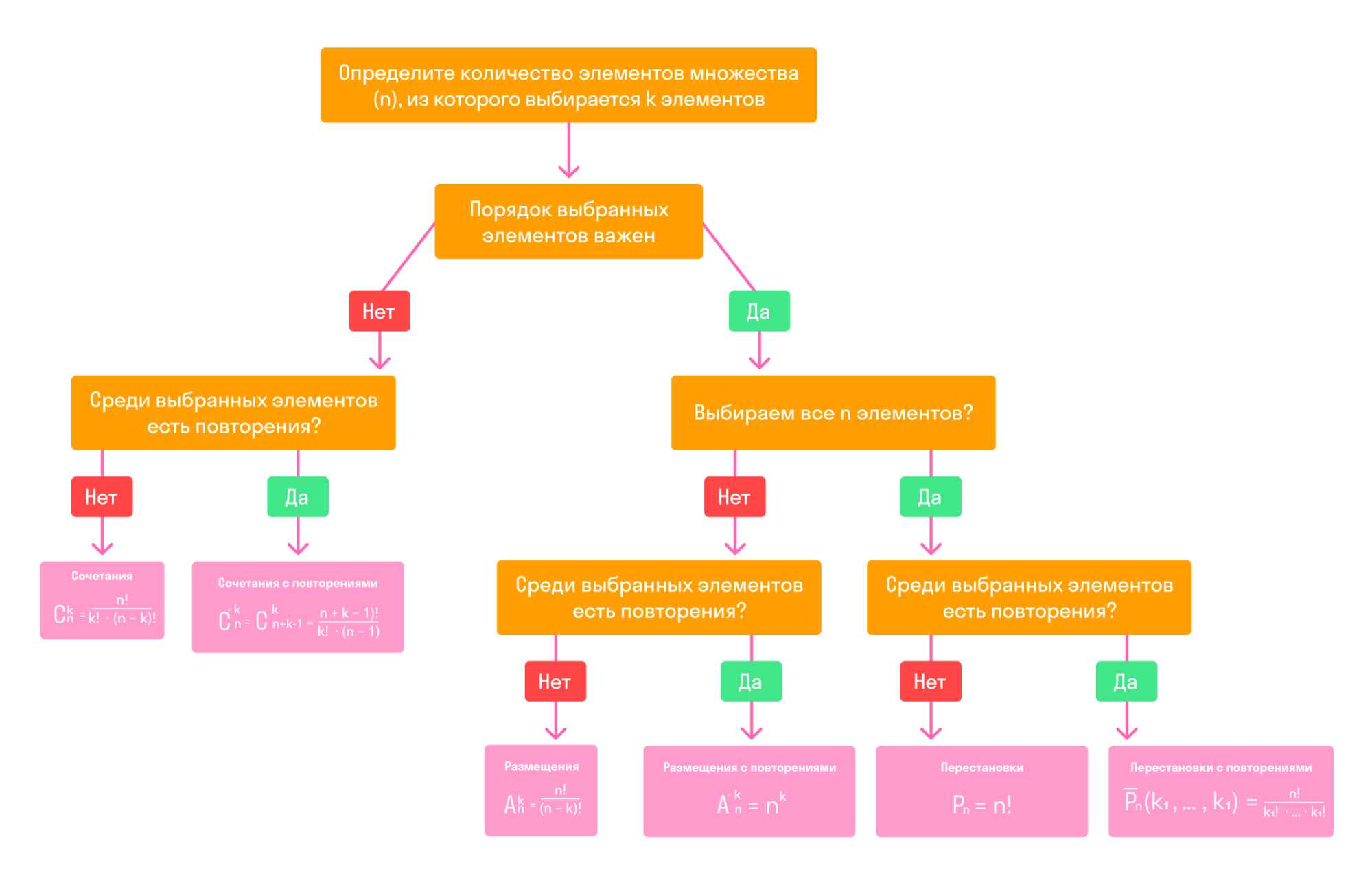

Случайные события. Основные формулы комбинаторики

Классическое определение вероятности

Вероятностью события A в некотором испытании называют отношение:

P (A) = m/n, где n — общее число всех равновозможных, элементарных исходов этого испытания, а m — количество элементарных исходов, благоприятствующих событию A

Таким образом, вероятность любого события удовлетворяет двойному неравенству:

Пример 1. В пакете 15 конфет: 5 с молочным шоколадом и 10 — с горьким. Какова вероятность вынуть из пакета конфету с белым шоколадом?

Так как в пакете нет конфет с белым шоколадом, то m = 0, n = 15. Следовательно, искомая вероятность равна нулю:

Неприятная новость для любителей белого шоколада: в этом примере событие «вынуть конфету с белым шоколадом» — невозможное.

Пример 2. Из колоды в 36 карт вынули одну карту. Какова вероятность появления карты червовой масти?

Количество элементарных исходов, то есть количество карт равно 36 (n). Число случаев, благоприятствующих появлению карты червовой масти (А) равно 9 (m).

Геометрическое определение вероятности

Геометрическая вероятность события А определяется отношением:

P(A)= m(A)/m(G), где m(G) и m(A) — геометрические меры (длины, площади или объемы) всего пространства элементарных исходов G и события А соответственно

Чаще всего, в одномерном случае речь идет о длинах отрезков, в двумерном — о площадях фигур, а в трехмерном — об объемах тел.

Пример. Какова вероятность встречи с другом, если вы договорились встретиться в парке в промежутке с 12.00 до 13.00 и ждете друг друга 5 минут?

У нас есть отличные курсы по математике для учеников с 1 по 11 классы — приглашаем на вводный урок!

Сложение и умножение вероятностей

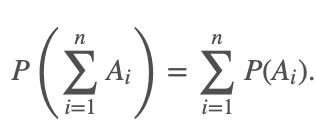

Теорема о сложении вероятностей звучит так: вероятность появления одного из двух несовместных событий равна сумме вероятностей этих событий:

P(A + B) = P(A) + P(B)

Эта теорема справедлива для любого числа несовместных событий:

Если случайные события A1, A2. An образуют полную группу несовместных событий, то справедливо равенство:

Произведением событий А и В называется событие АВ, которое наступает тогда, когда наступают оба события: А и В одновременно. Случайные события А и B называются совместными, если при данном испытании могут произойти оба эти события.

Вторая теорема о сложении вероятностей: вероятность суммы совместных событий вычисляется по формуле:

P(A + B) = P(A) + P(B) − P(AB)

События событий А и В называются независимыми, если появление одного из них не меняет вероятности появления другого. Событие А называется зависимым от события В, если вероятность события А меняется в зависимости от того, произошло событие В или нет.

Теорема об умножении вероятностей: вероятность произведения независимых событий А и В вычисляется по формуле:

P(AB) = P(A) * P(B)

Пример. Студент разыскивает нужную ему формулу в трех справочниках. Вероятности того, что формула содержится в первом, втором и третьем справочниках равны 0,6; 0,7 и 0,8.

Найдем вероятности того, что формула содержится:

А — формула содержится в первом справочнике;

В — формула содержится во втором справочнике;

С — формула содержится в третьем справочнике.

Воспользуемся теоремами сложения и умножения вероятностей.

Ответ: 1 — 0,188; 2 — 0,452; 3 — 0,336.

Формула полной вероятности и формула Байеса

|

По теореме умножения вероятностей:

Аналогично, для остальных гипотез:

Эта формула называется формулой Байеса. Вероятности гипотез называются апостериорными вероятностями, тогда как — априорными вероятностями.

Пример. Одного из трех стрелков вызывают на линию огня, он производит два выстрела. Вероятность попадания в мишень при одном выстреле для первого стрелка равна 0,3, для второго — 0,5; для третьего — 0,8. Мишень не поражена. Найти вероятность того, что выстрелы произведены первым стрелком.

Формула Бернулли

При решении вероятностных задач часто бывает, что одно и тоже испытание повторяется многократно, и исход каждого испытания независит от исходов других. Такой эксперимент называют схемой повторных независимых испытаний или схемой Бернулли.

Примеры повторных испытаний:

Итак, пусть в результате испытания возможны два исхода: либо появится событие А, либо противоположное ему событие. Проведем n испытаний Бернулли. Это означает, что все n испытаний независимы. А вероятность появления события А в каждом случае постоянна и не изменяется от испытания к испытанию.

Биномиальное распределение — распределение числа успехов (появлений события).

Пример. Среди видео, которые снимает блогер, бывает в среднем 4% некачественных: то свет плохой, то звук пропал, то ракурс не самый удачный. Найдем вероятность того, что среди 30 видео два будут нестандартными.

Опыт заключается в проверке каждого из 30 видео на качество. Событие А — это какая-то неудача (свет, ракурс, звук), его вероятность p = 0,04, тогда q = 0,96. Отсюда по формуле Бернулли можно найти ответ:

Ответ: вероятность плохого видео приблизительно 0,202. Блогер молодец🙂

Наивероятнейшее число успехов

Биномиальное распределение ( по схеме Бернулли) помогает узнать, какое число появлений события А наиболее вероятно. Формула для наиболее вероятного числа успехов k (появлений события) выглядит так:

Пример. В очень большом секретном чатике сидит 730 человек. Вероятность того, что день рождения наугад взятого участника чата приходится на определенный день года — равна 1/365 для каждого из 365 дней. Найдем наиболее вероятное число счастливчиков, которые родились 1 января.

Формула Пуассона

При большом числе испытаний n и малой вероятности р формулой Бернулли пользоваться неудобно. Например, 0.97 999 вычислить весьма затруднительно.

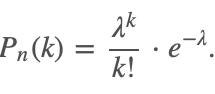

В этом случае для вычисления вероятности того, что в n испытаниях событие произойдет k раз, используют формулу Пуассона:

|

Здесь λ = np обозначает среднее число появлений события в n испытаниях.

Эта формула дает удовлетворительное приближение для p ≤ 0,1 и np ≤10.

События, для которых применима формула Пуассона, называют редкими, так как вероятность, что они произойдут — очень мала (обычно порядка 0,001-0,0001).

При больших np рекомендуют применять формулы Лапласа, которую рассмотрим чуть позже.

Пример. В айфоне 1000 разных элементов, которые работают независимо друг от друга. Вероятность отказа любого элемента в течении времени Т равна 0,002. Найти вероятность того, что за время Т откажут ровно три элемента.

P1000(3) = λ 3 /3! * e −λ = 2 3 /3! * e −2 ≈ 0,18.

Ответ: ориентировочно 0,18.

Теоремы Муавра-Лапласа

Кроме того, пусть Pn(k1;k2) — вероятность того, что число появлений события А находится между k1 и k2.

Локальная теорема Лапласа звучит так: если n — велико, а р — отлично от 0 и 1, то

Интегральная теорема Лапласа звучит так: если n — велико, а р — отлично от 0 и 1, то

Функции Гаусса и Лапласа обладают свойствами, которые пригодятся, чтобы правильно пользоваться таблицей значений этих функций:

Теоремы Лапласа дают удовлетворительное приближение при npq ≥ 9. Причем чем ближе значения q, p к 0,5, тем точнее данные формулы. При маленьких или больших значениях вероятности (близких к 0 или 1) формула дает большую погрешность по сравнению с исходной формулой Бернулли.

Теория вероятности что такое гипотеза

1. Статистические гипотезы. Основные понятия.

2. Гипотезы о законе распределения.

3. Гипотезы о числовом значении генерального среднего и дисперсии.

1. Статистические гипотезы. Основные понятия.

В тех случаях, когда известен закон, но неизвестны значения его параметров (дисперсия или математическое ожидание) в конкретной ситуации, статистическую гипотезу называют параметрической.

Например, предположение об ожидаемом среднем доходе по акциям или разбросе дохода являются параметрическими гипотезами.

Когда закон распределения генеральной совокупности не известен, но есть основания предположить, каков его конкретный вид, выдвигаемые гипотезы о виде его распределения называются непараметрическими.

Например, можно выдвинуть гипотезу, что число дневных продаж в магазине или доход населения подчинены нормальному закону распределения.

По содержанию статистические гипотезы можно классифицировать:

1. Гипотезы о типе вероятностного закона распределения случайной величины, характеризующего явление или процесс.

2. Гипотезы об однородности двух или более обрабатываемых выборок. Изучаемое свойство исследуется с помощью двух или более генеральных совокупностей. Гипотеза в этом случае может заключаться в следующем: исследуемые выборочные характеристики различаются между собой статистически значимо или нет.

3. Гипотезы о свойствах числовых значений параметров исследуемой генеральной совокупности. Больше ли значения параметров некоторого заданного номинала или меньше и т.д.

4. Гипотезы о вероятностной зависимости двух или более признаков, характеризующих различные свойства рассматриваемого явления или процесса. При этом определяется характер этой зависимости.

Гипотезы бывают простые (содержащие одно предположение) и сложные (содержащие несколько предположений).

Под статистическим критерием понимают однозначно определенное правило, устанавливающее условие, при котором проверяемая гипотеза отвергается либо не отвергается.

Увеличение числа заболевших некоторым заболеванием дает возможность выдвинуть гипотезу о наличии эпидемии. Для сравнения доли заболевших в обычных и экстремальных условиях используются статистические данные, на основании которых делается вывод о том, является ли данное массовое заболевание эпидемией. Предполагается, что существует некоторый критерий- уровень доли заболевших, критический для этого заболевания, который устанавливается по ранее имевшимся случаям.

Различают три вида критериев:

Проверка параметрических гипотез проводится на основе критериев значимости., а непараметрических- критериев согласия.

Задача проверки статистических гипотез сводится к исследованию генеральной совокупности по выборке. Множество возможных значений элементов выборки может быть разделено на два непересекающихся подмножества- критическую область и область принятия гипотезы.

Областью принятия гипотезы или областью допустимых значений Iдоп называют совокупность значений критерия, при которых эту гипотезу принимают.

Критической областью Iкр называют множество значений критерия, при котором гипотезу отвергают.

Наблюдаемые значения критерия (статистика) Kнабл называют такое значение критерия, которое находится по данным выборки.

С помощью уровня значимости определяются границы критической области.

Основной принцип проверки статистических гипотез состоит в следующем: если наблюдаемое значение статистики критерия попадает (не попадает) в критическую область, то гипотеза H0 отвергается (принимается), а гипотеза H1 принимается (отвергается) в качестве одного из возможных решений с формулировкой «гипотеза H0 противоречит (не противоречит) выборочным данным на уровне значимости ».

В зависимости от содержания альтернативной гипотезы осуществляется выбор критической области: левосторонней, правосторонней, двусторонней. Если смысл исследования заключается в доказательстве конкретного изменения наблюдаемого параметра (его уменьшения или увеличения), то говорят об односторонней критической области. Если смысл исследования- выявить различия в изучаемых параметрах, но характер их отклонения от контрольных (или теоретических) не известен, то говорят о двусторонней критической области.

Однако, принятие той или иной гипотезы не дает оснований утверждать, что она верна. Результат проверки статистической гипотезы лишь устанавливают на определенном уровне значимости ее соответствие (несоответствие) результатам эксперимента.

При проверке статистических гипотез возможны следующие ошибки:

2. Отвергнута правильная альтернативная гипотеза H1 и принята неправильная нулевая гипотеза H0 — ошибка второго рода.

Можно доказать, что с уменьшением ошибок первого рода одновременно увеличиваются ошибки второго рода и наоборот. Поэтому, на практике пытаются подбирать значения параметров и опытным путем в целях минимизации суммарного эффекта от возможных ошибок. При принятии управленческих решений для одновременного уменьшения ошибок первого и второго рода самым действенным средством является увеличение объема выборки, что согласуется с законом больших чисел.

На бытовом уровне ошибки второго рода могут иметь более трагические последствия, чем ошибки первого рода.

2. Гипотеза о законе распределения. Критерий согласия Пирсона ( X 2 -критерий).

Критериями согласия называют критерии, в которых гипотеза определяет закон распределения либо полностью, либо с точностью до небольшого числа параметров.

Причины расхождения результатов эксперимента и теоретических характеристик могут быть вызваны малым объемом выборки, неудачным способом группировки наблюдений, ошибками в выборе гипотезы о виде распределения генеральной совокупности и др.

Рассмотрим универсальный критерий согласия Пирсона. Проверка гипотезы о том, что эмпирическая частота мало отличается от соответствующей теоретической частоты, осуществляется с помощью величины X 2 — меры расхождения между ними.

Для произвольной выборки, когда распределение непрерывно или число различных вариант велико, все пространство наблюдаемых вариант делят на конечное число непересекающихся областей, в каждой из которых подсчитывают наблюдаемую частоту и теоретическую вероятность.

Для применения критерия согласия Пирсона необходимо:

Понимаем теорему Байеса

Перевод статьи подготовлен специально для студентов базового и продвинутого курсов «Математика для Data Science».

Теорема Байеса – одна из самых известных теорем в статистике и теории вероятности. Даже если вы не работаете с расчетами количественных показателей, вероятно, вам в какой-то момент пришлось познакомиться с этой теоремой во время подготовки к экзамену.

Вот так она выглядит, но что это значит и как работает? Сегодня мы это узнаем и углубимся в теорему Байеса.

Основания для подтверждения наших суждений

В чем вообще заключается смысл теории вероятности и статистики? Одно из наиболее важных применений относится к принятию решений в условиях неопределенности. Когда вы принимаете решение совершить какое-либо действие (если, конечно, вы человек разумный), вы делаете ставку на то, что после завершения этого действия оно повлечет за собой результат лучший, чем если бы этого действия не произошло… Но ставки – это вещь ненадежная, как же вы в конечном итоге принимаете решение делать ли тот или иной шаг или нет?

Так или иначе вы оцениваете вероятность успешного исхода, и, если эта вероятность выше определенного порогового значения, вы предпринимаете шаг.

Таким образом, возможность точно оценить вероятность успеха имеет решающее значение для принятия правильных решений. Несмотря на то, что случайность всегда будет играть определенную роль в конечном исходе, вам следует учиться правильно использовать эти случайности и оборачивать их в свою пользу с течением времени.

Именно здесь вступает в силу теорема Байеса – она дает нам количественную основу для сохранения нашей веры в исход действия по мере изменений окружающих факторов, что, в свою очередь, позволяет нам со временем совершенствовать процесс принятия решений.

Разберем формулу

Давайте еще раз посмотрим на формулу:

P(A|B) – это пример апостериорной (условной) вероятности, то есть такой, которая измеряет вероятность какого-то определенного состояния окружающего мира (а именно состояния, при котором произошло событие В). Тогда как P(A) – это пример априорная вероятности, которая может быть измерена при любом состоянии окружающего мира.

Давайте посмотрим на теорему Байеса в действии на примере. Предположим, что недавно вы закончили курс по анализу данных от bootcamp. Вы еще не получили ответа от некоторых компаний, в которых вы проходили собеседование, и начинаете волноваться. Итак, вы хотите рассчитать вероятность того, что конкретная компания сделает вам предложение об устройстве на работу, при условии, что уже прошло три дня, а они вам так и не перезвонили.

Перепишем формулу в терминах нашего примера. В данном случае, исход А (Offer) – это получения предложения о работе, а исход В (NoCall) – «отсутствие телефонного звонка в течение трех дней». Исходя из этого, нашу формулу можно переписать так:

Значение P(Offer|NoCall) — это вероятность получения предложения при условии, что звонка нет в течение трех дней. Эту вероятность оценить крайне сложно.

Однако обратной вероятности, P(NoCall|Offer), то есть отсутствию телефонного звонка в течение трех дней, при учете, что в итоге вы получили предложение о работе от компании, вполне можно привязать какое-то значение. Из разговоров с друзьями, рекрутерами и консультантами вы узнаете, что эта вероятность небольшая, но иногда компания все же может сохранять тишину в течение трех дней, если она все еще планирует пригласить вас на работу. Итак, вы оцениваете:

40% — это неплохо и кажется, еще есть надежда! Но мы еще не закончили. Теперь нам нужно оценить P(Offer), вероятность выхода на работу. Все знают, что поиск работы – это долгий и трудный процесс, и возможно вам придется проходить собеседование несколько раз, прежде чем вы получите это предложение, поэтому вы оцениваете:

Теперь нам осталось оценить P(NoCall), вероятность, что вы не получите звонок от компании в течение трех дней. Существует множество причин, по которым вам могут не перезвонить в течение трех дней – они могут отклонить вашу кандидатуру или до сих пор проводить собеседования с другими кандидатами, или рекрутер просто заболел и поэтому не звонит. Что ж, есть множество причин, по которым вам могли не позвонить, так что эту вероятность вы оцениваете как:

А теперь собрав это все вместе, мы можем рассчитать P(Offer|NoCall):

Это довольно мало, так что, к сожалению, рациональнее оставить надежду на эту компанию (и продолжать отправлять резюме в другие). Если это все еще кажется немного абстрактным, не переживайте. Я чувствовал то же самое, когда впервые узнал про теорему Байеса. Теперь давайте разберемся, как мы пришли к этим 8,9% (имейте в виду, что ваша изначальная оценка в 20% уже была низкой).

Интуиция, стоящая за формулой

Помните, мы говорили о том, что теорема Байеса дает основания для подтверждения наших суждений? Так откуда же они берутся? Они берутся из априорной вероятности P(A), которая в нашем примере зовется P(Offer), по сути, это и есть наше изначальное суждение том, насколько вероятно, что человек получит предложение о работе. В нашем примере вы можете считать, что априорная вероятность – это вероятность того, что вы получите предложение о работе в тот же момент, когда покинете собеседование.

Появляется новая информация – прошло 3 дня, а компания вам так и не перезвонила. Таким образом мы используем другие части уравнения, чтобы скорректировать нашу априорную вероятность нового события.

Давайте рассмотрим вероятность P(B|A), которая в нашем примере называется P(NoCall|Offer). Когда вы впервые видите теорему Байеса, вы задаетесь вопросом: Как понять откуда взять вероятность P(B|A)? Если я не знаю, чему равна вероятность P(A|B), то каким магическом образом я должен узнать, чему равна вероятность P(B|A)? Я вспоминаю фразу, которую однажды сказал Чарльз Мангер:

«Переворачивайте, всегда переворачивайте!»

— Чарльз Мангер

Он имел в виду, что, когда вы пытаетесь решить сложную задачу, ее нужно перевернуть с ног на голову и посмотреть на нее под других углом. Именно это и делает теорема Байеса. Давайте переформулируем теорему Байеса в терминах статистики, чтобы сделать ее более понятной (об это я узнал отсюда):

Для меня, например, такая запись выглядит понятнее. У нас есть априорная гипотеза (Hypothesis) — о том, что мы получили работу, и наблюдаемые факты — доказательства (Evidence) – телефонного звонка нет в течение трех дней. Теперь мы хотим узнать вероятность того, что наша гипотеза верна, с учетом предоставленных фактов. Как бы решили выше, у нас есть вероятность P(A) = 20%.

Время переворачивать все с ног на голову! Мы используем P(Evidence|Hypothesis), чтобы посмотреть на задачу с другой стороны и спрашиваем: «Какова вероятность наступления этих событий-доказательств в мире, где наша гипотеза верна?». Итак, если вернуться к нашему примеру, мы хотим знать, насколько вероятно, что, если нам не звонят в течение трех дней, нас все равно возьмут на работу. В изображении выше я пометил P(Evidence|Hypothesis), как “scaler” (скейлер), потому что это слово хорошо отражает суть значения. Когда мы умножаем его на априорное значение, он уменьшает или увеличивает вероятность события, в зависимости от того «вредит» ли какое-либо событие-доказательство нашей гипотезе. В нашем случае, чем больше дней проходит без звонка, тем меньше вероятность того, что нас позовут на работу. 3 дня тишины – это уже плохо (они сокращают нашу априорную вероятность на 60%), тогда как 20 дней без звонка полностью уничтожат надежду на получение работы. Таким образом, чем больше накапливается событий-доказательств (больше дней проходит без телефонного звонка), тем быстрее скейлер уменьшает вероятность. Скейлер – это механизм, который теорема Байеса использует для корректировки наших суждений.

Есть одна вещь, с которой я боролся в оригинальной версии этой статьи. Это была формулировка того, почему P(Evidence|Hypothesis) легче оценить, чем P(Hypothesis|Evidence). Причина этого заключается в том, что P(Evidence|Hypothesis) – это гораздо более ограниченная область суждений о мире. Сужая область, мы упрощаем задачу. Можно провести аналогию с огнем и дымом, где огонь – это наша гипотеза, а наблюдение дыма – событие, доказывающее наличие огня. P(огонь|дым) оценить сложнее, поскольку много чего может вызвать дым – выхлопные газы автомобилей, фабрики, человек, который жарит гамбургеры на углях. При этом P(дым|огонь) оценить проще, поскольку в мире, где есть огонь, почти наверняка будет и дым.

Значение вероятности уменьшается по мере того, сколько проходит дней без звонка.

Последняя часть формулы, P(B) или же P(Evidence) – это нормализатор. Как следует из названия, его цель – нормализовать произведение априорной вероятности и скейлера. Если бы у на не было нормализатора, мы бы имели следующее выражение:

Заметим, что произведение априорной вероятности и скейлера равно совместной вероятности. И поскольку одно из составляющих в нем P(Evidence), то на совместную вероятность повлияла бы маленькая частота событий.

Это проблема, поскольку совместная вероятность – это значение, включающее в себя все состояния мира. Но нам то не нужны все состояния, нам нужны только те состояния, которые были подтверждены событиями-доказательствами. Другими словами, мы живем в мире, где события – доказательства уже произошли, и их количество уже не имеет значения (поэтому мы не хотим, чтобы они влияли на наши расчеты в принципе). Деление произведения априорной вероятности и скейлера на P(Evidence) меняет его с совместной вероятности на условную(апостериорную). Условная вероятность учитывает только те состояния мира, в которых произошло событие-доказательство, именно этого мы и добиваемся.

Еще одна точка зрения, с которой можно взглянуть на то, почему мы делим скейлер на нормализатор, заключается в том, что они отвечают на два важных вопроса – и их отношение объединяет эту информацию. Давайте возьмем пример из моей недавней статьи про Байеса. Предположим, мы пытаемся выяснить, является ли наблюдаемое животное кошкой, основываясь на единственном признаке – ловкости. Все, что мы знаем, так это то, что животное, о котором мы говорим, проворное.

Подведем итог

Теперь, когда мы знаем, как трактовать каждую часть формулы, мы можем наконец собрать все воедино и посмотреть на то, что получилось: